Der Leitfaden zur Interviewanalyse

- Was ist eine Interviewanalyse?

- Vorteile von Interviews in der Forschung

- Nachteile von Interviews in der Forschung

- Ethische Überlegungen bei Interviews

- Vorbereitung eines Forschungsinterviews

- Rekrutierung und Stichprobenauswahl für Forschungsinterviews

- Interview Design

- Wie man Interviewfragen formuliert

- Vertrauensverhältnis in Interviews

- Soziale Erwünschtheit

- Interviewer-Effekt

- Arten von Forschungsinterviews

- Persönliche Interviewforschung

- Fokusgruppen-Interviews

- E-Mail-Interviews

- Telefoninterviews

- Stimulierte Erinnerungsinterviews

- Interviews vs. Umfragen

- Interviews vs. Fragebögen

- Interviews und Verhöre

- Wie transkribiert man Interviews?

- Verbatim Transkription

- Saubere Interviewtranskriptionen

- Manuelle Transkription von Interviews

- Automatisierte Transkription von Interviews

- Wie kommentiert man Forschungsinterviews?

- Formatierung und Anonymisierung von Interviews

-

Interviews analysieren

- Einführung

- Methoden für die Interviewanalyse

- Thematische Analyse

- Narrative Analyse

- Fundierte Theorie

- Inhaltliche Analyse

- Diskursanalyse

- Rahmenanalyse

- Phänomenologische Analyse

- Weniger gängige Methoden zur Analyse von Interviewdaten

- Wie kann ATLAS.ti bei der Analyse von Interviewdaten helfen?

- Schlussfolgerung

- Kodierung von Interviews

- Berichterstattung und Präsentation der Interviewergebnisse

- Wie man den „Leitfaden zur Interviewanalyse“ zitiert

Analyse von Interviews

Ohne den Prozess der Interviewanalyse ist qualitative Forschung nicht möglich. Interviews sind die häufigste Methode der Datenerhebung, die qualitative Forscher verwenden. Dieser Artikel befasst sich mit verschiedenen Methoden zur Analyse von qualitativen Daten aus Interviews.

Einführung

Die Analyse von Interviews in der qualitativen Forschung erschließt eine einzigartige Perspektive, einen Gedanken oder ein Gefühl. Interviews liefern reichhaltige, tiefgehende Daten, die den Forschern einen unvergleichlichen Einblick in die gelebten Erfahrungen, Meinungen und Werte der Teilnehmer bieten. Die effektive Analyse qualitativer Daten erfordert jedoch mehr als nur das Zuhören; sie erfordert einen systematischen Ansatz, um die tiefere Bedeutung der Worte aufzudecken. Die verschiedenen Methoden der qualitativen Interviewdatenanalyse sind der Schlüssel zur Umwandlung von Rohgesprächen in aussagekräftige Erkenntnisse.

Von der Identifizierung von Mustern in qualitativen Interviews bis hin zur Anwendung von Techniken zur Analyse von qualitativen Interviewdaten, diese Methoden helfen Forschern, komplexe Informationen in handhabbare Teile zu zerlegen. Der Kodierungsprozess ist besonders wichtig, da er es den Forschern ermöglicht, Daten zu markieren und zu kategorisieren und sie so in etwas zu verwandeln, das analysiert und interpretiert werden kann. Durch die Kodierung qualitativer Daten können Forscher Themen und Schlüsseldatensegmente identifizieren, die zugrunde liegende Trends und Bedeutungen aufzeigen. Darüber hinaus fügt der Einsatz modernerer Ansätze wie der Stimmungsanalyse der Interpretation eine weitere Ebene hinzu und hilft dabei, die in den Antworten enthaltenen Emotionen und Reaktionen zu erfassen.

Methoden für die Interviewanalyse

In der qualitativen Forschung sind die Methoden der Interviewanalyse unerlässlich, um die tieferen Bedeutungen, Muster und Einsichten in den Antworten der Teilnehmer aufzudecken. Von der thematischen Analyse, die gemeinsame Themen in den Interviews identifiziert, bis hin zur Grounded Theory, die neue Theorien aus den Daten entwickelt, bietet jede Methode einen einzigartigen Ansatz. Die Wahl der Methode hängt von den Forschungszielen, der Art der Daten und der Art der Erkenntnisse ab, die der Forscher erreichen will. Interviewanalysemethoden ermöglichen eine strukturierte und dennoch flexible Interpretation qualitativer Daten und liefern wertvolle Erkenntnisse, die zur breiteren Forschungslandschaft beitragen.

Thematische Analyse

Thematische Analyse ist eine der am häufigsten verwendeten Methoden in der qualitativen Forschung, um Muster oder Themen in Daten zu identifizieren, zu analysieren und zu berichten. Sie ermöglicht es Forschern, Daten aus Interviewtranskripten oder anderen qualitativen Quellen zu destillieren, um Gemeinsamkeiten und Trends zu finden, die reichhaltige Interpretationen ermöglichen. Braun und Clarke (2006) beschreiben die thematische Analyse als eine flexible Methode, die in einer Vielzahl von Forschungsparadigmen angewandt werden kann und sich zur Identifizierung von Themen eignet, die sich über den gesamten Datensatz erstrecken. Die Methode ist weit verbreitet, da sie einen systematischen Weg zur Erfassung von Mustern in den Perspektiven der Teilnehmer bietet.

Vertrautmachen mit den Daten

Der Forscher macht sich zunächst eingehend mit den Daten vertraut, indem er die Interviewtranskripte wiederholt durchliest, sich die Aufnahmen anhört und erste Notizen macht. Diese Phase ist entscheidend für das Eintauchen in den Datensatz und ermöglicht es dem Forscher, erste Eindrücke zu gewinnen und den Kontext der Daten zu verstehen.

Erstellung erster Codes

Der Forscher kodiert dann systematisch die Daten, indem er Textabschnitten, die wichtige oder wiederkehrende Ideen erfassen, Etiketten oder kurze Sätze zuweist. Jeder Code steht für ein wichtiges Konzept oder eine Beobachtung, und dieser Schritt hilft dabei, die Daten in überschaubare, kategorisierte Teile zu zerlegen.

Suche nach Themen

Sobald die Daten kodiert wurden, überprüft der Forscher die Codes, um übergreifende Themen oder Muster zu finden. Dazu werden verwandte Codes gruppiert und allgemeinere Themen identifiziert, die sich im gesamten Datensatz abzeichnen. Die Themen gehen über die Codes hinaus, um größere Bedeutungsmuster zu erfassen.

Überprüfen und Verfeinern von Themen

In dieser Phase werden die Themen anhand der kodierten Daten und des gesamten Datensatzes überprüft, um sicherzustellen, dass sie umfassend sind und die Daten korrekt wiedergeben. Der Forscher verfeinert die Themen, indem er sie je nach Bedarf kombiniert oder trennt, um die wichtigsten Erkenntnisse aus den Daten bestmöglich zu erfassen.

Definieren und Benennen von Themen

Sobald die Themen überprüft wurden, werden sie definiert und benannt, um das Wesen der Daten, die sie repräsentieren, widerzuspiegeln. Der Forscher schreibt eine detaillierte Beschreibung jedes Themas, erklärt seine Relevanz für die Forschungsfrage und untermauert sie mit Datenauszügen.

Verfassen des Berichts

In der letzten Phase wird der Bericht verfasst, der eine ausführliche Darstellung enthält, in der erklärt wird, wie die Themen ermittelt wurden, was sie bedeuten und wie sie die Forschungsfrage beantworten. Der Bericht enthält direkte Zitate der Teilnehmer und eine Synthese der thematischen Ergebnisse.

Erzählerische Analyse

Die narrative Analyse ist eine Methode, die sich auf die Geschichten konzentriert, die die Teilnehmer erzählen, und darauf, wie diese Geschichten strukturiert sind, um ihren Erfahrungen einen Sinn zu geben. Riessman (2008) betonte, dass die narrative Analyse über den Inhalt dessen, was erzählt wird, hinausgeht und auch die Art und Weise, wie es erzählt wird, sowie die Kontexte, die diese Geschichten formen, berücksichtigt. Diese Methode eignet sich besonders für die Untersuchung persönlicher oder kollektiver Geschichten, der Identitätsbildung und von Prozessen der Sinnstiftung.

Transkription und Strukturierung

Der Forscher transkribiert zunächst die Interviews und achtet dabei nicht nur genau darauf, was gesagt wird, sondern auch darauf, wie es gesagt wird. Bei der Transkription wird der Erzählfluss erfasst, und der Forscher beginnt, wichtige Strukturelemente wie Anfang, Mitte und Ende der Geschichte sowie Wendepunkte oder kritische Ereignisse zu identifizieren.

Thematische und funktionale Analyse

Nach der Transkription der Daten analysiert der Forscher den Inhalt der Geschichten auf wiederkehrende Themen oder Themen, die in den Erzählungen der Teilnehmer eine zentrale Rolle spielen. Der funktionale Aspekt der Erzählanalyse konzentriert sich darauf, warum die Geschichte auf eine bestimmte Weise erzählt wird und welche Funktion die Erzählung im Kontext des Lebens oder der Identität des Teilnehmers hat.

Vergleichende Analyse

Bei der Analyse mehrerer Erzählungen suchen die Forscher nach Ähnlichkeiten und Unterschieden in der Art und Weise, wie Teilnehmer ihre Geschichten konstruieren. Durch den Vergleich von Erzählungen kann der Forscher gemeinsame Erfahrungen oder Perspektiven identifizieren, die umfassendere Muster in den Daten erkennen lassen.

Interpretation und Geschichtenerzählen

Der letzte Schritt besteht darin, die Erzählungen zu interpretieren, um Erkenntnisse darüber zu gewinnen, wie die Teilnehmer ihren Erfahrungen einen Sinn geben. Der Forscher kann bestimmte narrative Strategien der Teilnehmer hervorheben, z. B. wie sie ihre Handlungen rechtfertigen oder erklären, um tiefere Einblicke in ihre gelebten Erfahrungen zu erhalten.

Grundlagentheorie

Grounded Theory, wie sie von Glaser und Strauss (1967) eingeführt wurde, beinhaltet den Aufbau einer Theorie aus den Daten selbst, anstatt bestehende Theorien zu testen. Charmaz (2006) hat später einen konstruktivistischen Ansatz zur Grounded Theory beigetragen. Die Grounded Theory ist besonders wertvoll, wenn es keine bereits bestehende Theorie zur Erklärung des untersuchten Phänomens gibt oder wenn der Forscher eine neue Theorie aufstellen will.

Open Koding

In der Phase des offenen Kodierens zerlegt der Forscher die Interviewdaten in kleine, diskrete Teile und kodiert sie auf der Grundlage der vorhandenen Konzepte oder Ideen. Diese erste Kodierung ist sehr detailliert und dient dazu, so viele Konzepte wie möglich in den Daten zu identifizieren.

Axiales Kodieren

Nach dem offenen Kodieren geht es beim axialen Kodieren darum, die beim offenen Kodieren identifizierten Kodes miteinander in Beziehung zu setzen. Bei diesem Prozess werden die Kodes in Kategorien eingeteilt und Beziehungen zwischen ihnen identifiziert, um ein strukturierteres Verständnis der Daten zu schaffen. Ziel ist es, herauszufinden, wie die Kategorien zusammenhängen und welche zentralen Themen sich herauskristallisieren.

Selektives Kodieren

Beim selektiven Kodieren geht es darum, die Kernkategorie zu identifizieren, die alle anderen Kategorien integriert. Der Forscher entwickelt diese Kernkategorie zum zentralen Thema oder zur Theorie der Studie. Selektives Kodieren ist wesentlich für die Entwicklung einer Theorie, die die Daten umfassend erklärt.

Theoretisches Sampling und Sättigung

Während sich die Theorie herauskristallisiert, sammelt der Forscher weitere Daten, um die Theorie zu verfeinern, ein Prozess, der als theoretisches Sampling bekannt ist. Die Datenerhebung wird so lange fortgesetzt, bis eine theoretische Sättigung erreicht ist, d. h. keine neuen Themen oder Erkenntnisse mehr aus den Daten hervorgehen und die Theorie vollständig entwickelt ist.

Theorieentwicklung

In der letzten Phase stellt der Forscher die Theorie vor, die aus den Daten entwickelt wurde. Diese Theorie stützt sich auf die Daten und bietet einen Erklärungsrahmen für das untersuchte Phänomen, der neue Einsichten oder ein neues Verständnis ermöglicht.

Inhaltsanalyse

Die Inhaltsanalyse ist eine systematische Methode zur Quantifizierung und Analyse des Vorkommens bestimmter Wörter, Phrasen, Themen oder Konzepte in Textdaten. Krippendorff (1980) definierte die Inhaltsanalyse als eine wiederholbare Technik, die es ermöglicht, von Daten auf ihren Kontext zu schließen und große Mengen qualitativer Daten systematisch zu untersuchen. Diese Methode ist besonders nützlich, wenn Forscher die Häufigkeit bestimmter Themen oder Muster in den Daten objektiv messen müssen.

Datenaufbereitung

Der Forscher beginnt mit der Vorbereitung der Daten für die Analyse, in der Regel durch Transkription, wenn er mit Interviewdaten arbeitet. In diesem Schritt werden die Daten geordnet und bereinigt, um die Konsistenz des Textes zu gewährleisten.

Entwicklung von Kategorien und Kodierungsrahmen

Als Nächstes entwickelt der Forscher einen Kodierungsrahmen, eine Liste von vordefinierten Kategorien oder Themen, die auf den Forschungsfragen oder dem theoretischen Rahmen basieren. Jede Kategorie wird definiert, und es werden klare Kriterien dafür festgelegt, wie Segmente der Daten den einzelnen Kategorien zugeordnet werden.

Kodierung des Textes

Der Forscher wendet den Kodierrahmen systematisch auf die Daten an und kennzeichnet die Textabschnitte, die den einzelnen Kategorien entsprechen. Die Kodierung kann je nach Größe des Datensatzes manuell oder mit Hilfe von Software erfolgen.

Quantifizierung und Interpretation

Bei der quantitativen Inhaltsanalyse zählt der Forscher die Häufigkeit der einzelnen Kodes oder Themen, um Muster und Trends zu erkennen. Diese Häufigkeiten werden dann interpretiert, um Rückschlüsse darauf zu ziehen, welche Themen in den Daten am stärksten ausgeprägt sind oder wie sich verschiedene Themen zueinander verhalten.

Schlussfolgerungen ziehen und berichten

Der letzte Schritt ist die Interpretation der kodierten Daten und die Präsentation der Ergebnisse in einem Bericht. Der Forscher erörtert die Bedeutung der am häufigsten auftretenden Themen und zieht Schlussfolgerungen aus den Datenmustern und ihrer Relevanz für die Forschungsfragen.

Diskursanalyse

Die Diskursanalyse untersucht, wie Sprache verwendet wird, um soziale Realitäten und Beziehungen zu konstruieren. Fairclough (1992) betonte, dass der Diskurs nicht nur ein Spiegelbild sozialer Praktiken ist, sondern diese auch aktiv gestaltet. Die Diskursanalyse erforscht Machtverhältnisse, Ideologien und soziale Kontexte durch die Analyse von Sprache und bietet Einblicke in die Art und Weise, wie soziale Strukturen und Machtdynamiken durch Kommunikation erzeugt und aufrechterhalten werden.

Transkription und Kontextualisierung

Der erste Schritt der Diskursanalyse umfasst die Transkription von Interviews oder Gespräche, wobei sowohl die verbale als auch die nonverbale Kommunikation berücksichtigt wird. Dabei wird sowohl die verbale als auch die nonverbale Kommunikation berücksichtigt. Die Forscher berücksichtigen auch den breiteren sozialen oder institutionellen Kontext, in dem der Diskurs stattfindet, da dieser Kontext eine wichtige Rolle bei der Gestaltung des Sprachgebrauchs spielt.

Identifizierung von Diskursen

Nach der Transkription identifiziert der Forscher bestimmte Diskurse oder Redeweisen über das Thema, die in dem Text vorkommen. Diese Diskurse spiegeln bestimmte Weltanschauungen, Ideologien oder Machtverhältnisse wider, und die Forscherin untersucht, wie sie das Verständnis des Themas beeinflussen.

Analyse des Sprachgebrauchs

Der Forscher konzentriert sich auf die im Diskurs verwendeten sprachlichen Merkmale, wie Wortwahl, Metaphern, Tonfall und Satzstruktur. Diese Merkmale zeigen, wie soziale Normen, Machtdynamiken und Ideologien in die Alltagssprache eingebettet sind.

Untersuchung von Macht und Ideologie

Diskursanalyse untersucht, wie Sprache Machtverhältnisse und soziale Hierarchien stärkt oder in Frage stellt. Die Forscher untersuchen, wie bestimmte Diskurse bestimmte Standpunkte privilegieren oder andere ausgrenzen, und beleuchten die Rolle der Sprache bei der Aufrechterhaltung der sozialen Ordnung.

Interpretation und Auswirkungen

In der letzten Phase interpretiert der Forscher die Ergebnisse und erörtert die Implikationen der ermittelten Diskurse. Die Analyse könnte aufzeigen, wie Sprache zu sozialen Ungleichheiten beiträgt oder wie sie zur Durchsetzung von Autorität oder zur Legitimierung bestimmter Praktiken in einem bestimmten Kontext eingesetzt wird.

Framework-Analyse

Die Rahmenanalyse kann verwendet werden, wenn die Forschung vordefinierte Ziele oder Fragen hat. Sie wurde ursprünglich von Ritchie und Spencer (2003) entwickelt und ist in der angewandten Forschung weit verbreitet, z. B. in der politischen Analyse oder in Studien zum Gesundheitswesen. Der Ansatz ist strukturiert und transparent, so dass er sich gut für große Datensätze eignet. Die Rahmenanalyse ermöglicht die Organisation der Daten in Themen und Unterthemen innerhalb einer Matrix, wodurch sichergestellt wird, dass die Daten rigoros untersucht und mit den Forschungszielen in Einklang gebracht werden. Durch die Verwendung von Matrizen wird sichergestellt, dass die Daten sowohl thematisch als auch fallweise geordnet sind und eine klare Struktur für Vergleiche bieten.

Einarbeitung

In einem ersten Schritt taucht der Forscher in die Daten ein, indem er die Transkripte, Feldnotizen oder Dokumente gründlich durchliest. Diese erste Phase ist entscheidend, um ein umfassendes Verständnis der Daten zu erlangen. Die Forscher machen sich oft Notizen und markieren erste Ideen, die ihnen wichtig erscheinen.

Identifizierung eines thematischen Rahmens

Nach der Einarbeitung wird ein thematischer Rahmen entwickelt. Dieser Rahmen ergibt sich aus den zentralen Forschungsfragen, der Theorie oder den vorläufigen Ergebnissen der Einarbeitung. Der Rahmen dient als Leitfaden für die Analyse der Daten und setzt sich aus wichtigen Themen und Unterthemen zusammen.

Indexierung

Der Forscher wendet den thematischen Rahmen auf die Daten an, indem er Abschnitte der Daten entsprechend den relevanten Themen indexiert oder kodiert. Der Indexierungsprozess verknüpft bestimmte Teile der Daten mit relevanten Themen aus dem Rahmenwerk und stellt sicher, dass jeder Datenabschnitt systematisch kategorisiert wird.

Charting

In dieser Phase werden die Daten in eine Matrix eingeordnet. In der Matrix werden die Daten nach Themen (Zeilen) und einzelnen Fällen oder Teilnehmern (Spalten) geordnet, wodurch ein strukturiertes Format entsteht, das einen einfachen Vergleich zwischen verschiedenen Fällen ermöglicht. Bei der Erstellung des Diagramms werden die Daten der einzelnen Fälle unter den entsprechenden thematischen Überschriften zusammengefasst.

Kartierung und Interpretation

In der letzten Phase werden die Daten innerhalb des Rahmens analysiert und Muster, Beziehungen und Kontraste zwischen den Themen und Fällen identifiziert. Die Forscher stellen die wichtigsten Ergebnisse dar, ziehen Schlussfolgerungen auf der Grundlage des thematischen Rahmens und verwenden die Matrix, um sicherzustellen, dass alle relevanten Aspekte der Daten berücksichtigt werden. Diese Phase ist entscheidend für die Entwicklung von Erkenntnissen, die die Forschungsfragen beantworten.

Phänomenologische Analyse

Die phänomenologische Analyse ist eine Methode zur Erforschung und zum Verständnis der gelebten Erfahrungen des Einzelnen. Sie basiert auf der philosophischen Tradition der Phänomenologie, die versucht, das Wesen von Erfahrungen aufzudecken. Der Ansatz von van Manen (1990) ist wertvoll, wenn sich die Forschung darauf konzentriert, wie Individuen spezifische Phänomene wie Krankheit, Verlust oder Lebensübergänge erleben und wahrnehmen. Die Analyse zielt darauf ab, den Reichtum dieser Erfahrungen zu erfassen und sie in wesentliche Themen zu destillieren, die den Kern des Phänomens beschreiben.

Bracketing

Der Forscher beginnt damit, seine vorgefassten Meinungen und Annahmen über das zu untersuchende Phänomen beiseite zu legen. Dies ist wichtig, um sicherzustellen, dass sich die Analyse ausschließlich auf die Erfahrungen der Teilnehmer konzentriert, ohne dass der Forscher die Interpretation beeinflusst.

Eintauchen in die Daten

Der Forscher liest die Interviewtranskripte und nimmt die Beschreibungen der Teilnehmer über ihre Erfahrungen vollständig auf. In dieser Phase achtet der Forscher auf signifikante Phrasen oder Sätze, die sich als Schlüssel zum Verständnis der Erfahrungen der Teilnehmer erweisen.

Identifizierung von Themen

Aus den Daten werden Schlüsselthemen extrahiert, die wesentliche Aspekte der Erfahrungen der Teilnehmer widerspiegeln. Diese Themen beziehen sich häufig auf Emotionen, Wahrnehmungen und Reaktionen auf bestimmte Situationen und stellen die Gemeinsamkeiten zwischen den Berichten der verschiedenen Teilnehmer dar.

Synthetisieren von Themen

Nach der Identifizierung der Themen fasst der Forscher diese zu einer kohärenten Beschreibung zusammen, die das Wesentliche der gelebten Erfahrung wiedergibt. Dazu gehört, die Bedeutung hinter jedem Thema zu interpretieren und zu verstehen, wie die Themen miteinander zusammenhängen.

Verfassen der Ergebnisse

Der Abschlussbericht enthält eine ausführliche, detaillierte Darstellung des Phänomens, in der die wesentlichen Themen hervorgehoben und die wichtigsten Punkte durch Zitate der Teilnehmer veranschaulicht werden. Ziel ist es, die Ergebnisse so zu präsentieren, dass die Tiefe und Komplexität der Erfahrungen der Teilnehmer deutlich wird.

Weniger gängige Methoden zur Analyse von Interviewdaten

Gesprächsanalyse

Die Gesprächsanalyse (Conversational Analysis, CA) ist eine Methode zur Untersuchung der Struktur und des Musters von Gesprächen in sozialen Interaktionen. Sie wurde von Sacks, Schegloff und Jefferson (1974) entwickelt und konzentriert sich darauf, zu verstehen, wie sich Gespräche in Echtzeit entfalten, indem sie die Turn-Taking-Mechanismen, Reparaturen und Sequenzen im Dialog analysiert. CA zielt darauf ab, die impliziten Regeln und sozialen Normen aufzudecken, die das alltägliche Gespräch bestimmen. Diese Methode ist besonders nützlich für die Untersuchung von Mikrointeraktionen zwischen Individuen, wie sie z. B. bei Interviews, Debatten oder zwanglosen Gesprächen auftreten.

Transkription

Der Forscher beginnt mit der detaillierten Transkription des Gesprächs, wobei er genau auf Pausen, Unterbrechungen, Überschneidungen, den Tonfall und andere nonverbale Hinweise achtet. Die Transkription ist in der Regel sehr detailliert, wobei Symbole verwendet werden, um Timing, Betonung und Veränderungen in den Sprachmustern anzuzeigen.

Analyse der Gesprächsführung

Ein Hauptaugenmerk der CA liegt darauf, zu verstehen, wie die Sprecher das Turn-Taking in Gesprächen handhaben. Der Forscher untersucht, wie die Teilnehmer signalisieren, wann sie sprechen möchten, wie sie sich abwechseln und wie sie anderen das Wort überlassen. Diese Analyse offenbart die sozialen Normen, die den Gesprächsfluss steuern.

Schnittstellenorganisation

Gespräche folgen oft bestimmten Sequenzen (z. B. Frage-Antwort-Paare, Begrüßungen und Antworten). Forscher analysieren, wie sich diese Sequenzen entfalten und wie die Teilnehmer den erwarteten Interaktionsfluss aufrechterhalten oder stören. Dazu gehört auch die Analyse, wie durch diese Sequenzen Bedeutung konstruiert wird.

Repair-Mechanismen

Wenn es zu Missverständnissen oder Gesprächsabbrüchen kommt, setzen die Teilnehmer häufig Reparaturstrategien ein, um die Interaktion wieder in Ordnung zu bringen. Die Forscher untersuchen, wie die Teilnehmer diese Probleme angehen, und suchen nach Mustern, wie sie ihre Sprache klären, wiederholen oder umformulieren.

Schlussfolgerung und soziale Auswirkungen

Auf der Grundlage der Analyse zieht der Forscher Schlussfolgerungen über die sozialen Normen und Regeln, die für Gesprächsinteraktionen gelten. Diese Analyse trägt dazu bei, breitere soziale Strukturen und Erwartungen aufzuzeigen, die sich in der alltäglichen Kommunikation widerspiegeln.

Interpretative phänomenologische Analyse (IPA)

Die interpretative phänomenologische Analyse (IPA) ist eine qualitative Forschungsmethode, die darauf abzielt zu erforschen, wie Individuen ihren persönlichen und sozialen Erfahrungen einen Sinn geben. Sie ist in der Phänomenologie und Hermeneutik verwurzelt und konzentriert sich darauf, die Bedeutung hinter gelebten Erfahrungen zu verstehen. Smith, Flowers und Larkin (2009) waren maßgeblich an der Entwicklung der IPA als Forschungsmethode beteiligt und betonten deren Einsatz in den Bereichen Psychologie, Gesundheit und Bildung. IPA ist besonders nützlich für Studien, die subjektive Erfahrungen erforschen, wie z. B. die Bewältigung von Krankheiten oder die Bewältigung persönlicher Herausforderungen, und sie ermöglicht ein tiefes, interpretatives Verständnis der Daten.

Lesen und Eintauchen

Der Forscher beginnt mit dem Eintauchen in die Interviewtranskripte, indem er die Berichte der Teilnehmer sorgfältig liest und reflektiert. Dieser Schritt stellt sicher, dass sich der Forscher voll und ganz auf die Daten einlässt, bevor er zur Analyse übergeht.

Erstkodierung

Der Forscher identifiziert signifikante Elemente in den Daten, indem er Abschnitte des Transkripts mit Codes versieht. Diese Codes erfassen die Bedeutung der Erfahrungen der Teilnehmer in prägnanter Form und bilden die Grundlage für die spätere Themenentwicklung.

Themenentwicklung

Nach der Kodierung sucht der Forscher nach Mustern oder Themen in den Daten. Die Themen spiegeln die wichtigsten Anliegen und Bedeutungen der Teilnehmer wider und helfen zu erklären, wie die Teilnehmer ihren Erfahrungen einen Sinn geben. Die Themen werden gruppiert und strukturiert, um ihre Beziehungen widerzuspiegeln.

Interpretation

Der Forscher geht über die Beschreibung der Themen hinaus und interpretiert die tiefere Bedeutung, die ihnen zugrunde liegt. Dieser Interpretationsprozess beinhaltet das Verständnis der gelebten Erfahrungen der Teilnehmer in ihrem breiteren sozialen und psychologischen Kontext.

Synthese und Berichterstattung

In der letzten Phase wird ein Bericht verfasst, der Themen und Interpretationen zusammenführt und einen detaillierten und nuancierten Bericht darüber liefert, wie die Teilnehmer ihre Welt erleben und ihr einen Sinn geben. Zur Veranschaulichung von Schlüsselthemen werden direkte Zitate der Teilnehmer verwendet.

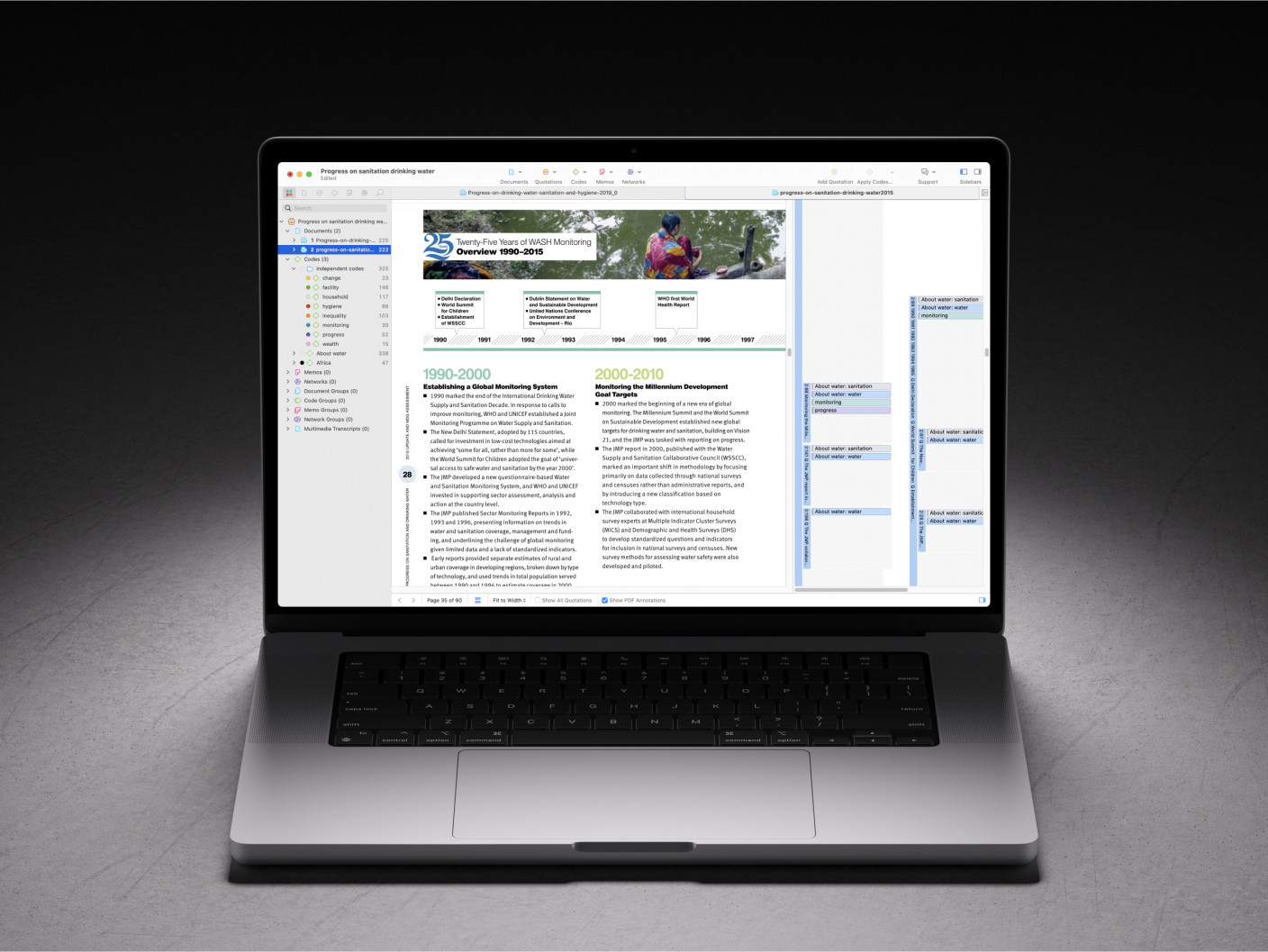

Wie kann ATLAS.ti bei der Analyse von Interviewdaten helfen?

ATLAS.ti ist eine fortschrittliche qualitative Analysesoftware, die Forschern hilft, Interviewdaten effizient zu verwalten und zu analysieren. Egal, ob Sie alleine oder im Team arbeiten, mit Text-, Audio- oder Videoformaten, ATLAS.ti bietet eine breite Palette von Tools, die den Kodierungs- und Interpretationsprozess erleichtern.

Import von Interviewtranskripten und -aufzeichnungen: Forscher können Interviewdaten einfach importieren und mit der Identifizierung von Schlüsselthemen beginnen, indem sie relevante Textsegmente hervorheben oder Zeitstempel in Mediendateien annotieren.

Reflexionen und Notizen in Memos schreiben: Eines der wichtigsten Werkzeuge für Forscher sind Memos, in denen Sie Erkenntnisse, Überlegungen und aufkommende Ideen während des gesamten Analyseprozesses dokumentieren können, um sicherzustellen, dass wichtige Beobachtungen festgehalten werden.

Kodieren Sie Ihre Daten gemäß der von Ihnen gewählten Methodik: Das Kodieren und Analysieren von Daten in ATLAS.ti ist extrem flexibel, so dass Sie die Methodik anwenden können, die für Ihre Forschung am besten geeignet ist. Sie können jedes Datensegment markieren, Notizen machen und Kodes anbringen. Erstellen Sie Ihre eigenen Kodes, verwenden Sie In-vivo-Kodes, nutzen Sie bereits vorhandene Kodes oder erkunden Sie sogar von der KI vorgeschlagene Kodes.

Nutzen Sie KI als virtuellen Assistenten: ATLAS.ti enthält auch eine breite Palette von KI-gesteuerten Tools, die sich wiederholende Aufgaben automatisieren und einen anderen Blickwinkel auf die Daten bieten können.

Absolute KI-Kodierung: Generiert automatisch deskriptive Kodes durch die Analyse Ihrer Interviewtranskripte. Dies hilft bei der Identifizierung von Schlüsselthemen und -ausdrücken.

Konversations-KI: Stellen Sie beliebige Fragen zu Ihren Daten in natürlicher Sprache, und der KI-gesteuerte Chatbot gibt Antworten auf der Grundlage der von Ihnen ausgewählten Daten. Er zeigt Ihnen auch die Datensegmente an, auf denen seine Antworten basieren, so dass Sie Ihren gesamten Datensatz leicht erkunden können.

Gefühlsanalyse: Dieses Tool analysiert den emotionalen Ton des Textes und kodiert automatisch positive, negative und neutrale Stimmungen in Ihren Interviewdaten. Es hilft Forschern, die Einstellungen und Reaktionen der Teilnehmer schnell zu bewerten.

Erkennung benannter Entitäten (NER): KI identifiziert wichtige Entitäten wie Namen, Organisationen und Orte in Ihrem Text und bietet so eine schnellere Möglichkeit zur Kodierung wichtiger Elemente in den Interviews.

Konzepterkennung: Hebt automatisch relevante Konzepte oder Schlüsselwörter hervor und präsentiert eine Wortwolke, die das Verständnis der Hauptthemen und Unterthemen des Interviews erleichtert.

Meinungsanalyse: Diese Funktion analysiert Meinungen und Stimmungen im Zusammenhang mit identifizierten Konzepten und hilft dabei, die Ansichten und Einstellungen der Teilnehmer tiefer zu ergründen.

Visualisieren Sie Ihre Daten und Analysen in Netzwerken: Verwenden Sie Netzwerke, um Ideen zu sammeln, konzeptionelle Rahmen zu erstellen oder einfach die Geschichte Ihrer Forschung darzustellen. Jeder Teil Ihres Projekts kann in einem Netzwerk visualisiert werden, einschließlich Datenzitate, Kodehäufigkeiten und Ihre Notizen.

Zeigen Sie Ihre Daten an, um übergreifende Muster zu untersuchen: Untersuchen Sie die Häufigkeit von Kodes in Ihren Daten und untersuchen Sie die Muster des gemeinsamen Auftretens Ihrer Kodes mit Tools, die Ihre Daten in Tabellen, Diagrammen und Sankey-Diagrammen anzeigen. So können Sie das Gesamtbild Ihrer Forschung untersuchen und differenziertere Erkenntnisse gewinnen.

Schlussfolgerung

Die Interviewanalyse ist das Herzstück der qualitativen Forschung. Sie verwandelt unbearbeitete Gespräche in reichhaltige, aussagekräftige Erkenntnisse, die unser Verständnis der menschlichen Erfahrungen prägen. Durch den Einsatz strukturierter und systematischer Ansätze wie der thematischen Analyse, der Grounded Theory oder der narrativen Analyse können Forscher die zugrunde liegenden Muster und Themen in qualitativen Daten aufdecken. Diese Methoden helfen bei der Analyse qualitativer Daten und ermöglichen eine tiefere Erforschung individueller Perspektiven und kollektiver Erfahrungen, die wertvolle Erkenntnisse für die Forschungslandschaft liefern. Tools wie ATLAS.ti verbessern diesen Prozess noch weiter, indem sie den Kodierungsprozess vereinfachen, bei der Identifizierung von Themen helfen und einen robusten Rahmen für die Analyse qualitativer Interviewdaten bieten. Ob es nun darum geht, eine Theorie zu entwickeln oder verborgene Gefühle durch eine Stimmungsanalyse aufzudecken, eine effektive Interviewanalyse ist unerlässlich, um komplexe menschliche Interaktionen in klare, umsetzbare Forschungsergebnisse zu übersetzen.

Referenzen

- Braun, V., & Clarke, V. (2006). Die Anwendung der thematischen Analyse in der Psychologie. Qualitative Forschung in der Psychologie, 3(2), 77-101. https://doi.org/10.1191/1478088706qp063oa

- Charmaz, K. (2006). Aufbau einer fundierten Theorie: Ein praktischer Leitfaden durch die qualitative Analyse. Sage Publications.

- Glaser, B., & Strauss, A. (1967). The discovery of grounded theory: Strategien für die qualitative Forschung. Aldine Publishing.

- Krippendorff, K. (1980). Content analysis: Eine Einführung in ihre Methodik. Sage Publications.

- Ritchie, J., Spencer, L., & O'Connor, W. (2003). Carrying out qualitative analysis. In J. Ritchie & J. Lewis (Eds.), Qualitative research practice: A guide for social science students and researchers (S. 219-262). Sage Publications.

- Riessman, C. K. (2008). Narrative methods for the human sciences. Sage Publications.

- Fairclough, N. (1992). Diskurs und sozialer Wandel. Polity Press.

- van Manen, M. (1990). Die Erforschung gelebter Erfahrung: Humanwissenschaft für eine handlungssensible Pädagogik. SUNY Press.

- Sacks, H., Schegloff, E. A., & Jefferson, G. (1974). Eine einfachste Systematik für die Organisation des Turn-Taking bei Gesprächen. Language, 50(4), 696-735. https://doi.org/10.2307/412243

- Smith, J. A., Flowers, P., & Larkin, M. (2009). Interpretative phänomenologische Analyse: Theorie, Methode und Forschung. Sage Publications.

- Hsieh, H.-F., & Shannon, S. E. (2005). Drei Ansätze zur qualitativen Inhaltsanalyse. Qualitative Gesundheitsforschung, 15(9), 1277-1288. https://doi.org/10.1177/1049732305276687