La Guía del Análisis de Entrevistas

- ¿Qué es el Análisis de Entrevistas?

- Ventajas de Entrevistas de Investigación

- Desventajas de Entrevistas de Investigación

- Ética en las Entrevistas de Investigación

- Cómo Preparar una Entrevista de Investigación

- Reclutamiento y Muestreo para Entrevistas de Investigación

- Diseño de la Entrevista

- Cómo Formular Preguntas de Entrevista

- Rapport en las Entrevistas

- Sesgo de Deseabilidad Social

- Efecto del Entrevistador

- Tipos de Entrevistas de Investigación

- Entrevistas Cara a Cara

- Grupos Focales

- Entrevistas por Correo Electrónico

- Entrevistas Telefónicas

- ¿Qué es una entrevista de recuerdo estimulado?

- Entrevistas vs. Encuestas

- Entrevistas vs. Cuestionarios

- Entrevistas e Interrogatorios

- ¿Cómo transcribir entrevistas?

- Transcripción Literal

- Transcripción Limpia de Entrevistas

- Transcripción Manual de Entrevistas

- Transcripción Automática de Entrevistas

- ¿Cómo Anotar Entrevistas de Investigación?

- Formatear y Anonimizar Transcripciones de Entrevistas

-

Análisis de Entrevistas

- Introducción

- Métodos de análisis de las entrevistas

- Análisis temático

- Análisis narrativo

- Teoría fundamentada

- Análisis del contenido

- Análisis del discurso

- Análisis de marcos

- Análisis fenomenológico

- Métodos menos habituales de análisis de datos de entrevistas

- ¿Cómo puede ATLAS.ti ayudar con el análisis de datos de entrevistas?

- Conclusión

- Codificación de Entrevistas

- Presentación de los resultados de las entrevistas

- Cómo citar "La Guía del Análisis de Entrevistas"

Análisis de Entrevistas

Sin el proceso de análisis de entrevistas, la investigación cualitativa es imposible. Las entrevistas son el método más común de recogida de datos que utilizan los investigadores cualitativos. Este artículo se centra en diferentes métodos de análisis de datos cualitativos procedentes de entrevistas.

Introducción

El análisis de las entrevistas en la investigación cualitativa permite descubrir una perspectiva, un pensamiento o una emoción únicos. Las entrevistas proporcionan datos ricos y profundos que ofrecen a los investigadores una visión sin parangón de las experiencias vividas, las opiniones y los valores de los participantes. Sin embargo, para analizar eficazmente los datos cualitativos no basta con escuchar, sino que se requiere un enfoque sistemático para descubrir el significado más profundo que encierran las palabras. Los distintos métodos de análisis de datos de entrevistas cualitativas son fundamentales para transformar las conversaciones en bruto en percepciones significativas.

Desde la identificación de patrones a través de entrevistas cualitativas hasta el empleo de técnicas de análisis de datos de entrevistas cualitativas, estos métodos ayudan a los investigadores a descomponer la información compleja en partes manejables. El proceso de codificación es especialmente importante, ya que permite a los investigadores etiquetar y categorizar los datos, transformándolos en algo que puede analizarse e interpretarse. Mediante codificación los datos cualitativos, los investigadores pueden identificar temas y segmentos de datos clave que revelan tendencias y significados subyacentes. Además, el uso de enfoques más modernos, como el análisis de sentimientos, añade otra capa a la interpretación, ayudando a calibrar las emociones y reacciones implícitas en las respuestas.

Métodos de análisis de las entrevistas

En la investigación cualitativa, los métodos de análisis de entrevistas son esenciales para descubrir los significados más profundos, los patrones y las percepciones de las respuestas de los participantes. Desde el análisis temático, que identifica temas comunes en todas las entrevistas, hasta la teoría fundamentada, que construye nuevas teorías a partir de los datos, cada método ofrece un enfoque único. La elección del método depende de los objetivos de la investigación, la naturaleza de los datos y el tipo de información que el investigador quiera obtener. Los métodos de análisis de entrevistas permiten una interpretación estructurada pero flexible de los datos cualitativos, proporcionando valiosos hallazgos que contribuyen a ampliar el panorama de la investigación.

Análisis temático

El Análisis temático es uno de los métodos más utilizados en la investigación cualitativa para identificar, analizar y comunicar patrones o temas dentro de los datos. Permite a los investigadores destilar datos de las transcripciones de entrevistas u otras fuentes cualitativas para encontrar puntos en común y tendencias, ofreciendo interpretaciones ricas. Braun y Clarke (2006) describen el análisis temático como un método flexible que puede aplicarse a diversos paradigmas de investigación y es adecuado para identificar temas que abarcan todo el conjunto de datos. El método se utiliza ampliamente porque proporciona una forma sistemática de captar patrones en las perspectivas de los participantes.

Familiarización con los datos

En primer lugar, el investigador se familiariza profundamente con los datos leyendo repetidamente las transcripciones de las entrevistas, escuchando las grabaciones y tomando notas iniciales. Esta fase es crucial para la inmersión en el conjunto de datos, ya que permite al investigador empezar a formarse impresiones iniciales y comprender el contexto de los datos.

Generación de códigos iniciales

A continuación, el investigador codifica sistemáticamente los datos asignando etiquetas o frases cortas a segmentos de texto que captan ideas significativas o recurrentes. Cada código representa un concepto u observación importante, y este paso ayuda a descomponer los datos en partes manejables y categorizadas.

Búsqueda de temas

Una vez codificados los datos, el investigador revisa los códigos para encontrar temas o patrones generales. Esto implica agrupar códigos relacionados e identificar temas más amplios que surjan en el conjunto de datos. Los temas van más allá de los códigos para captar patrones de significado más amplios.

Revisión y perfeccionamiento de los temas

En esta fase, los temas se cotejan con los datos codificados y con el conjunto de datos para garantizar que son exhaustivos y representan fielmente los datos. El investigador perfecciona los temas, combinándolos o separándolos según sea necesario para captar mejor las ideas clave de los datos.

Definición y denominación de los temas

Una vez revisados los temas, se definen y se les da un nombre que refleje la esencia de los datos que representan. El investigador redacta descripciones detalladas de cada tema, explicando su relevancia para la pregunta de investigación y apoyándolo con extractos de datos.

Redacción del informe

La fase final consiste en redactar el informe, que incluye una narración detallada en la que se explica cómo se identificaron los temas, qué significan y cómo responden a la pregunta de investigación. La redacción integra citas directas de los participantes y una síntesis de las conclusiones temáticas.

Análisis narrativo

El análisis narrativo es un método que se centra en las historias que cuentan los participantes y en cómo se estructuran esas historias para dar sentido a sus experiencias. Riessman (2008) destacó que el análisis narrativo va más allá del contenido de lo que se cuenta para incluir cómo se cuenta y los contextos que dan forma a estas historias. Este método es especialmente útil para explorar historias personales o colectivas, la formación de la identidad y los procesos de creación de significado.

Transcripción y estructuración

En primer lugar, el investigador transcribe las entrevistas presta especial atención no sólo a lo que se dice, sino también a cómo se dice. El proceso de transcripción capta el flujo narrativo, y el investigador empieza a identificar elementos estructurales clave como el principio, el medio y el final de la historia, así como puntos de inflexión o acontecimientos críticos.

Análisis temático y funcional

Tras transcribir los datos, el investigador analiza el contenido de los relatos en busca de temas recurrentes o temas centrales en las narraciones de los participantes. El aspecto funcional del análisis narrativo se centra en por qué se cuenta la historia de una manera determinada y qué función cumple la narración en el contexto de la vida o la identidad del participante.

Análisis comparativo

Al analizar varias narraciones, los investigadores buscan similitudes y diferencias en la forma en que los participantes construyen sus historias. Al comparar las narraciones, el investigador puede identificar experiencias o perspectivas comunes que revelen patrones más amplios en los datos.

Interpretación y narración de historias

El último paso consiste en interpretar los relatos para comprender cómo los participantes dan sentido a sus experiencias. El investigador puede destacar estrategias narrativas específicas utilizadas por los participantes, como la forma en que justifican o explican sus acciones, para proporcionar una visión más profunda de sus experiencias vividas.

Teoría fundamentada

La teoría fundamentada, tal y como fue introducida por Glaser y Strauss (1967), implica la construcción de la teoría a partir de los propios datos, en lugar de poner a prueba las teorías existentes. Charmaz (2006) aportó posteriormente un enfoque constructivista a la teoría fundamentada. La teoría fundamentada es especialmente valiosa cuando no existe una teoría preexistente que explique el fenómeno estudiado, o cuando el investigador pretende construir una nueva teoría.

Codificación abierta

En la fase de codificación abierta, el investigador descompone los datos de la entrevista en partes pequeñas y discretas y las codifica basándose en los conceptos o ideas presentes. Esta codificación inicial es muy detallada y sirve para identificar el mayor número posible de conceptos en los datos.

Codificación axial

Tras la codificación abierta, la codificación axial consiste en relacionar entre sí los códigos identificados durante la codificación abierta. Este proceso organiza los códigos en categorías, identificando las relaciones entre ellas para crear una comprensión más estructurada de los datos. El objetivo es averiguar cómo se relacionan las categorías y qué temas centrales emergen.

Codificación selectiva

La codificación selectiva se centra en identificar la categoría central que integra todas las demás categorías. El investigador desarrolla esta categoría central hasta convertirla en el tema central o la teoría del estudio. La codificación selectiva es esencial para construir una teoría que explique los datos de forma exhaustiva.

Muestreo teórico y saturación

A medida que emerge la teoría, el investigador recopila más datos para refinarla, un proceso conocido como muestreo teórico. La recopilación de datos continúa hasta que se alcanza la saturación teórica, lo que significa que no surgen nuevos temas o percepciones a partir de los datos, y la teoría está completamente desarrollada.

Desarrollo de la teoría

En la etapa final, el investigador presenta la teoría que se ha generado a partir de los datos. Esta teoría se fundamenta en los datos y proporciona un marco explicativo del fenómeno estudiado, ofreciendo nuevas percepciones o comprensiones.

Análisis de contenido

El análisis de contenido es un método sistemático utilizado para cuantificar y analizar la presencia de determinadas palabras, frases, temas o conceptos en los datos textuales. Krippendorff (1980) definió el análisis de contenido como una técnica replicable para hacer inferencias de los datos a su contexto, permitiendo el examen sistemático de grandes cantidades de datos cualitativos. Este método es especialmente útil cuando los investigadores necesitan medir objetivamente la frecuencia de ciertos temas o patrones en los datos.

Preparación de los datos

El investigador comienza preparando los datos para el análisis, normalmente mediante transcripción si trabaja con datos de entrevistas. Este paso implica organizar y limpiar los datos para garantizar la coherencia del texto.

Desarrollo de categorías y marco de codificación

A continuación, el investigador elabora un marco de codificación, una lista de categorías o temas predefinidos basados en las preguntas de la investigación o el marco teórico. Se define cada categoría y se establecen criterios claros sobre cómo se asignarán los segmentos de datos a cada categoría.

Codificación del texto

El investigador aplica sistemáticamente el marco de codificación a los datos, etiquetando los segmentos de texto que corresponden a cada categoría. La codificación puede hacerse manualmente o con ayuda de programas informáticos, dependiendo del tamaño del conjunto de datos.

Cuantificación e interpretación

En el análisis de contenido cuantitativo, el investigador cuenta la frecuencia de cada código o tema para identificar patrones y tendencias. A continuación, estas frecuencias se interpretan para extraer conclusiones sobre qué temas destacan más en los datos o cómo se relacionan entre sí los distintos temas.

Extracción de conclusiones y elaboración de informes

El último paso consiste en interpretar los datos codificados y presentar los resultados en un reporte. El investigador analiza la importancia de los temas más frecuentes, haciendo inferencias basadas en los patrones de los datos y su relevancia para las preguntas de la investigación.

Análisis del discurso

El análisis del discurso examina cómo se utiliza el lenguaje para construir realidades y relaciones sociales. Fairclough (1992) subraya que el discurso no es sólo un reflejo de las prácticas sociales, sino que las configura activamente. El análisis del discurso explora las relaciones de poder, las ideologías y los contextos sociales a través del análisis del lenguaje, ofreciendo una visión de cómo se producen y mantienen las estructuras sociales y las dinámicas de poder a través de la comunicación.

Transcripción y contextualización

El primer paso del análisis del discurso consiste en transcribir entrevistas o conversaciones, prestando atención tanto a la comunicación verbal como a la no verbal. Los investigadores también tienen en cuenta el contexto social o institucional más amplio en el que se produce el discurso, ya que este contexto desempeña un papel importante en la configuración del uso del lenguaje.

Identificación de discursos

Una vez transcrito, el investigador identifica los discursos específicos o formas de hablar sobre el tema que están presentes en el texto. Estos discursos reflejan visiones del mundo, ideologías o relaciones de poder particulares, y el investigador examina cómo influyen en la comprensión del tema.

Analizar el uso del lenguaje

El investigador se centra en las características del lenguaje utilizado en el discurso, como la elección de palabras, las metáforas, el tono y la estructura de las frases. Estas características revelan cómo las normas sociales, las dinámicas de poder y las ideologías están integradas en el lenguaje cotidiano.

Examinar el poder y la ideología

El análisis del discurso examina cómo el lenguaje refuerza o cuestiona las relaciones de poder y las jerarquías sociales. Los investigadores estudian cómo ciertos discursos privilegian determinados puntos de vista o marginan otros, arrojando luz sobre el papel del lenguaje en el mantenimiento del orden social.

Interpretación e implicaciones

En la fase final, el investigador interpreta las conclusiones y analiza las implicaciones de los discursos identificados. El análisis puede revelar cómo contribuye el lenguaje a las desigualdades sociales, o cómo se utiliza para afirmar la autoridad o legitimar determinadas prácticas en un contexto dado.

Análisis de marcos

El análisis de marcos puede utilizarse cuando la investigación tiene objetivos o preguntas predefinidos. Desarrollado inicialmente por Ritchie y Spencer (2003), se utiliza ampliamente en la investigación aplicada, como el análisis de políticas o los estudios sanitarios. Se trata de un enfoque estructurado y transparente, por lo que resulta muy adecuado para grandes conjuntos de datos. El análisis de marcos permite organizar los datos en temas y subtemas dentro de una matriz, lo que garantiza que los datos se examinen con rigor y se ajusten a los objetivos de la investigación. El uso de matrices garantiza que los datos se organicen tanto temáticamente como por casos, proporcionando una estructura clara para la comparación.

Familiarización

En el primer paso, el investigador se sumerge en los datos leyendo detenidamente las transcripciones, las notas de campo o los documentos. Esta fase inicial es crucial para obtener una comprensión exhaustiva de los datos. Los investigadores suelen tomar notas y subrayar las ideas iniciales que parecen significativas.

Identificación de un marco temático

Tras la familiarización, se elabora un marco temático. Este marco surge de las preguntas clave de la investigación, la teoría o las conclusiones preliminares durante la familiarización. El marco sirve de guía para analizar los datos y se compone de temas y subtemas importantes.

Indexación

El investigador aplica el marco temático a los datos indexando, o codificando, secciones de los datos según los temas pertinentes. El proceso de indexación vincula partes específicas de los datos con temas relevantes del marco, garantizando que cada sección de los datos se categorice sistemáticamente.

Gráficos

En esta fase, los datos se grafican en una matriz. La matriz organiza los datos por temas (filas) y casos individuales o participantes (columnas), creando un formato estructurado que facilita la comparación entre distintos casos. El proceso de representación gráfica consiste en resumir los datos de cada caso en los epígrafes temáticos correspondientes.

Mapeo e interpretación

La etapa final consiste en analizar los datos dentro del marco, identificando patrones, relaciones y contrastes entre los temas y los casos. Los investigadores trazan un mapa de los principales resultados, extrayendo conclusiones basadas en el marco temático y utilizando la matriz para asegurarse de que se tienen en cuenta todos los aspectos relevantes de los datos. Esta etapa es crucial para desarrollar perspectivas que respondan a las preguntas de la investigación.

Análisis fenomenológico

El análisis fenomenológico es un método utilizado para explorar y comprender las experiencias vividas por los individuos. Se basa en la tradición filosófica de la fenomenología, que busca descubrir la esencia de las experiencias. El enfoque de van Manen (1990) es valioso cuando la investigación se centra en cómo los individuos experimentan y perciben fenómenos específicos, como la enfermedad, la pérdida o las transiciones vitales. El análisis pretende captar la riqueza de estas experiencias, destilándolas en temas esenciales que describan la esencia del fenómeno.

Análisis

El investigador comienza poniendo entre paréntesis o dejando a un lado sus ideas preconcebidas y sus suposiciones sobre el fenómeno estudiado. Esto es esencial para garantizar que el análisis se centre únicamente en las experiencias de los participantes sin que el investigador influya en la interpretación.

Inmersión en los datos

El investigador lee y relee las transcripciones de entrevistas, absorbiendo plenamente las descripciones de las experiencias de los participantes. Durante esta fase, el investigador permanece atento a las frases u oraciones significativas que destacan como clave para comprender las experiencias de los participantes.

Identificación de temas

De los datos se extraen temas clave que reflejan aspectos esenciales de las experiencias de los participantes. Estos temas suelen estar relacionados con emociones, percepciones y reacciones ante situaciones concretas, y representan los puntos en común de los relatos de los distintos participantes.

Sintetizar temas

Una vez identificados los temas, el investigador los sintetiza en una descripción coherente que capte la esencia de la experiencia vivida. Esto implica interpretar el significado de cada tema y comprender cómo se interrelacionan.

Escribir las conclusiones

El informe final ofrece un relato rico y detallado del fenómeno, destacando los temas esenciales y utilizando citas de los participantes para ilustrar los puntos clave. El objetivo es presentar las conclusiones de forma que transmitan la profundidad y complejidad de las experiencias de los participantes.

Métodos menos habituales de análisis de datos de entrevistas

Análisis conversacional

El análisis conversacional (AC) es un método utilizado para examinar la estructura y el patrón del habla en las interacciones sociales. Desarrollado por Sacks, Schegloff y Jefferson (1974), se centra en comprender cómo se desarrollan las conversaciones en tiempo real, analizando los mecanismos de toma de turnos, las reparaciones y las secuencias dentro del diálogo. El AC pretende descubrir las reglas implícitas y las normas sociales que rigen la conversación cotidiana. Este método es especialmente útil para estudiar las microinteracciones entre individuos, como las que se producen durante entrevistas, debates o conversaciones casuales.

Transcripción

El investigador comienza transcribiendo la conversación en detalle, prestando especial atención a las pausas, las interrupciones, los solapamientos, el tono y otras señales no verbales. La transcripción suele ser muy detallada y se utilizan símbolos para indicar el tiempo, el énfasis y los cambios en los patrones del habla.

Análisis del turno de palabra

Uno de los principales objetivos del AC es entender cómo los hablantes gestionan la toma de turnos durante las conversaciones. El investigador examina cómo señalan los participantes cuándo desean hablar, cómo se turnan y cómo ceden la palabra a los demás. Este análisis revela las normas sociales que rigen el flujo conversacional.

Organización de la secuencia

Las conversaciones suelen seguir secuencias determinadas (por ejemplo, pares de pregunta-respuesta, saludos y respuestas). Los investigadores analizan cómo se desarrollan estas secuencias y cómo los participantes mantienen o interrumpen el flujo esperado de la interacción. Esto incluye analizar cómo se construye el significado a través de estas secuencias.

Mecanismos de reparación

Cuando se producen malentendidos o interrupciones en la conversación, los participantes suelen utilizar estrategias de reparación para arreglar la interacción. Los investigadores examinan cómo abordan los participantes estos problemas, buscando patrones en la forma en que aclaran, repiten o reformulan su discurso.

Conclusión e implicaciones sociales

A partir del análisis, el investigador extrae conclusiones sobre las normas y reglas sociales que rigen las interacciones conversacionales. Este análisis ayuda a revelar estructuras y expectativas sociales más amplias que se reflejan en la comunicación cotidiana.

Análisis fenomenológico interpretativo (IPA)

El análisis fenomenológico interpretativo (AFI) es un método de investigación cualitativa cuyo objetivo es explorar cómo los individuos dan sentido a sus experiencias personales y sociales. Tiene sus raíces en la fenomenología y la hermenéutica, y se centra en la comprensión del significado que subyace a las experiencias vividas. Smith, Flowers y Larkin (2009) han sido fundamentales en el desarrollo de la IPA como método de investigación, haciendo hincapié en su uso en psicología, salud y educación. La IPA es especialmente útil para estudios que exploran experiencias subjetivas, como el afrontamiento de enfermedades o la superación de retos personales, y permite una comprensión profunda e interpretativa de los datos.

Lectura e inmersión

El investigador comienza sumergiéndose en las transcripciones de las entrevistas, leyendo detenidamente y reflexionando sobre los relatos de los participantes. Este paso garantiza que el investigador está plenamente comprometido con los datos antes de pasar al análisis.

Codificación inicial

El investigador identifica los elementos significativos de los datos aplicando códigos a secciones de la transcripción. Estos códigos captan el significado de las experiencias de los participantes de forma concisa y constituyen la base para el desarrollo posterior de los temas.

Desarrollo temático

Tras la codificación, el investigador busca patrones o temas en los datos. Los temas reflejan las principales preocupaciones y significados de los participantes y ayudan a explicar el sentido que éstos dan a sus experiencias. Los temas se agrupan y estructuran para reflejar sus relaciones.

Interpretación

El investigador va más allá de la descripción de los temas para interpretar el significado más profundo que hay detrás de ellos. Este proceso interpretativo implica comprender las experiencias vividas por los participantes dentro de sus contextos sociales y psicológicos más amplios.

Síntesis e informe

La fase final consiste en redactar un informe que entrelaza temas e interpretaciones y ofrece un relato detallado y matizado de cómo los participantes experimentan y dan sentido a su mundo. Se utilizan citas directas de los participantes para ilustrar los temas clave.

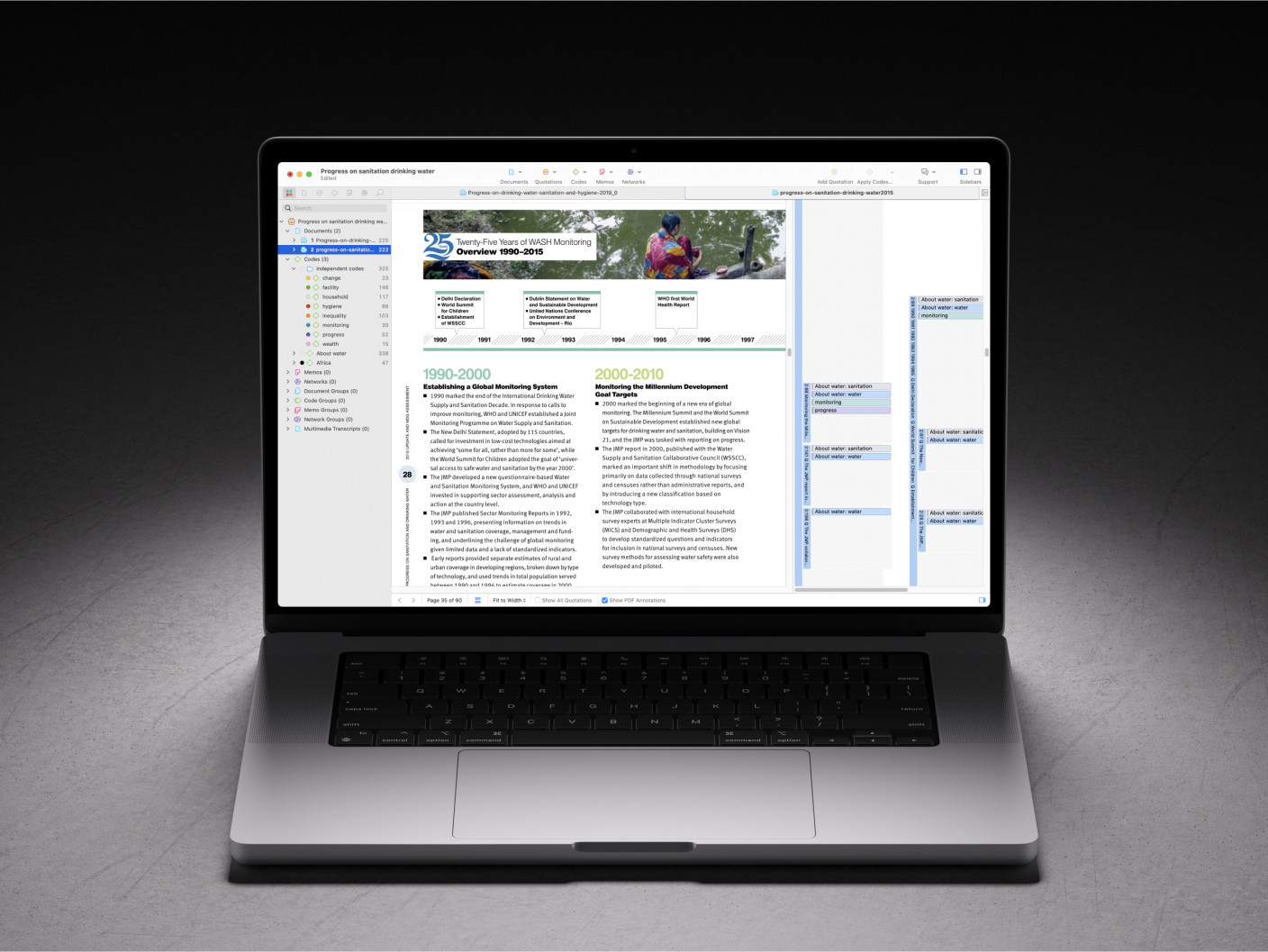

¿Cómo puede ayudar ATLAS.ti en el análisis de datos de entrevistas?

ATLAS.ti es un software avanzado de análisis cualitativo diseñado para ayudar a los investigadores a gestionar y analizar eficazmente los datos de las entrevistas. Tanto si trabaja solo como en equipo, con formatos de texto, audio o vídeo, ATLAS.ti proporciona una amplia gama de herramientas que facilitan el proceso de codificación e interpretación.

Importar transcripciones y grabaciones de entrevistas: Los investigadores pueden importar fácilmente datos de entrevistas y empezar a identificar temas clave resaltando segmentos relevantes de texto o anotando marcas de tiempo en archivos multimedia.

Escribir reflexiones y notas en memos: Una de las herramientas más importantes para los investigadores son los memos, en los que se pueden documentar percepciones, reflexiones e ideas emergentes a lo largo del proceso de análisis, garantizando que se capten las observaciones importantes.

Codificar los datos según la metodología elegida: Codificar y analizar datos en ATLAS.ti es extremadamente flexible, por lo que puede seguir la metodología que mejor se adapte a su investigación. Puede resaltar cualquier segmento de datos, escribir notas y adjuntar códigos. Cree sus propios códigos, utilice códigos in vivo, reutilice fácilmente códigos ya existentes, o incluso explore códigos sugeridos por la IA.

Utilice la IA como asistente virtual: ATLAS.ti también incluye una amplia gama de herramientas basadas en IA, que pueden automatizar tareas repetitivas y ofrecer una perspectiva diferente de los datos.

Codificación intencionada de IA: Genera automáticamente códigos descriptivos analizando las transcripciones de sus entrevistas. Ayuda a identificar temas y frases clave.

IA conversacional: Haga cualquier pregunta sobre sus datos utilizando lenguaje natural, y el chatbot impulsado por IA le proporcionará respuestas basadas en los datos seleccionados. También le mostrará los segmentos de datos en los que se basan sus respuestas, para que pueda explorar fácilmente todo su conjunto de datos.

Análisis de sentimientos: Esta herramienta analiza el tono emocional del texto, codificando automáticamente los sentimientos positivos, negativos y neutros de los datos de la entrevista. Ayuda a los investigadores a evaluar rápidamente las actitudes y reacciones de los participantes.

Reconocimiento de entidades con nombre (NER): La IA identifica entidades clave como nombres, organizaciones y ubicaciones dentro del texto, ofreciendo una forma más rápida de codificar elementos significativos en las entrevistas.

Detección de conceptos: Destaca automáticamente los conceptos o palabras clave relevantes, presentando una nube de palabras que ayuda a comprender los temas y subtemas principales de la entrevista.

Minería de opiniones: Esta función analiza las opiniones y sentimientos relacionados con los conceptos identificados, lo que ayuda a profundizar en las opiniones y actitudes de los participantes.

Visualice sus datos y análisis en redes: Utilice las redes para generar ideas, construir marcos conceptuales o, simplemente, dibujar la historia de su investigación. Cualquier parte de su proyecto puede visualizarse en una red, incluidas las citas de datos, las frecuencias de códigos y sus notas.

Visualice sus datos para explorar patrones generales: Examine las frecuencias de los códigos en sus datos y profundice en los patrones de co-ocurrencias entre sus códigos con herramientas que muestran sus datos en tablas, gráficos y diagramas de Sankey. Puede explorar el panorama general de su investigación y desarrollar perspectivas más matizadas.

Conclusión

El análisis de las entrevistas constituye el núcleo de la investigación cualitativa, ya que transforma las conversaciones en bruto en perspectivas ricas y significativas que dan forma a nuestra comprensión de las experiencias humanas. Mediante el empleo de enfoques estructurados y sistemáticos como análisis temático, teoría fundamentada o el análisis narrativo, los investigadores pueden descubrir los patrones y temas subyacentes en datos cualitativos. Estos métodos ayudan a analizar los datos cualitativos y permiten una exploración más profunda de las perspectivas individuales y las experiencias colectivas, aportando valiosos hallazgos al panorama de la investigación. Herramientas como ATLAS.ti mejoran aún más este proceso, simplificando el proceso de codificación, ayudando a identificar temas y proporcionando marcos sólidos para analizar los datos de las entrevistas cualitativas. Tanto si el objetivo es generar teoría como revelar sentimientos ocultos mediante el análisis de sentimientos, el análisis eficaz de las entrevistas es esencial para traducir interacciones humanas complejas en resultados de investigación claros y procesables.

Referencias

- Braun, V., y Clarke, V. (2006). Using thematic analysis in psychology. Qualitative Research in Psychology, 3(2), 77-101. https://doi.org/10.1191/1478088706qp063oa

- Charmaz, K. (2006). Constructing grounded theory: Una guía práctica a través del análisis cualitativo. Sage Publications.

- Glaser, B., y Strauss, A. (1967). El descubrimiento de la teoría fundamentada: Estrategias para la investigación cualitativa. Aldine Publishing.

- Krippendorff, K. (1980). Content analysis: Una introducción a su metodología. Sage Publications.

- Ritchie, J., Spencer, L., y O'Connor, W. (2003). Carrying out qualitative analysis. En J. Ritchie & J. Lewis (Eds.), Qualitative research practice: A guide for social science students and researchers (pp. 219-262). Sage Publications.

- Riessman, C. K. (2008). Métodos narrativos para las ciencias humanas. Sage Publications.

- Fairclough, N. (1992). Discourse and social change. Polity Press.

- van Manen, M. (1990). Researching lived experience: Human science for an action sensitive pedagogy. SUNY Press.

- Sacks, H., Schegloff, E. A., y Jefferson, G. (1974). A simplest systematics for the organization of turn-taking for conversation. Language, 50(4), 696-735. https://doi.org/10.2307/412243

- Smith, J. A., Flowers, P., & Larkin, M. (2009). Interpretative phenomenological analysis: Theory, method, and research. Sage Publications.

- Hsieh, H.-F. y Shannon, S. E. (2005). Three approaches to qualitative content analysis. Qualitative Health Research, 15(9), 1277-1288. https://doi.org/10.1177/1049732305276687