Der ultimative Leitfaden zur qualitativen Forschung - Teil 1: Die Grundlagen

- Einführung und Überblick

- Was ist qualitative Forschung?

- Was sind qualitative Daten?

- Beispiele für qualitative Daten

- Qualitative vs. quantitative Forschung

- Gemischte Methodik

- Vorbereitung qualitativer Forschung

- Theoretische Perspektive

- Theoretische Grundlagen

- Literaturstudien

- Forschungsfragen

- Der konzeptionelle Rahmen

- Konzeptioneller versus theoretischer Rahmen

- Datenerhebung

- Qualitative Forschungsmethoden

- Interviews

- Fokus-Gruppen

- Beobachtungsforschung

- Fallstudien

- Umfragen

- Ethnographische Forschung

- Ethische Erwägungen

- Vertraulichkeit und Datenschutz

- Voreingenommenheit

- Machtdynamik

- Reflexivität

- Wie zitiere ich "Der ultimative Leitfaden zur qualitativen Forschung - Teil 1: Die Grundlagen"

Datenerhebung - Was ist das und warum ist sie wichtig?

Die für Ihre Studie gesammelten Daten bilden die Grundlage für die Analyse Ihrer Forschungsarbeit. Eine transparente und gründliche Datenerhebung ist für den Rest Ihrer Forschung von Bedeutung und macht sie für Ihr Publikum überzeugend.

Wir werden uns mit dem Prozess der Datenerhebung, den Methoden der Datenerhebung, die es in der quantitativen und qualitativen Forschung gibt, und den verschiedenen Fragen rund um die Daten in der qualitativen Forschung beschäftigen.

Daten in der Forschung

Wenn es um die Definition von Daten geht, können Daten jede Art von Informationen sein, die Menschen nutzen, um die Welt um sie herum besser zu verstehen. Anhand dieser Informationen können wir solide Schlussfolgerungen ziehen und überprüfen, anstatt uns auf blinde Vermutungen oder Denkübungen zu verlassen.

Notwendigkeit von Fähigkeiten zur Datenerfassung

Das Sammeln von Daten ist von entscheidender Bedeutung für das grundlegende Ziel der Forschung als Instrument zur Organisation von Wissen. Auch wenn dies intuitiv erscheinen mag, ist es wichtig anzuerkennen, dass Forscher in der Datenerfassung ebenso geschickt sein müssen wie in der Datenanalyse.

Die richtigen Daten sammeln

Es geht nicht darum, so viele Daten wie möglich zu sammeln, sondern Daten, die für die Beantwortung Ihrer Forschungsfrage relevant sind. Stellen Sie sich eine einfache Forschungsfrage vor: Welche Faktoren berücksichtigen die Menschen beim Autokauf? Es wäre nicht möglich, jede lebende Person über ihre Autokäufe zu befragen. Selbst wenn es möglich wäre, fährt nicht jeder ein Auto, so dass es unproduktiv wäre, Nicht-Fahrer zu befragen. Folglich muss der Forscher, der eine Studie zur Erstellung von Datenberichten und Marketingstrategien durchführt, eine Stichprobe der relevanten Daten nehmen, um zuverlässige Analysen und Ergebnisse zu gewährleisten.

Beispiele für Datenerhebungen

Im weitesten Sinne trägt jede Art der Datenerhebung zum Forschungsprozess bei. In jeder wissenschaftlichen Arbeit können Forscher keine empirischen Schlussfolgerungen ziehen, ohne sich auf eine Reihe von Daten zu stützen, um rationale Urteile zu fällen.

Verschiedene Beispiele für die Datenerhebung in den Sozialwissenschaften sind:

- Antworten auf eine Umfrage über Produktzufriedenheit

- Interviews mit Studenten über ihre beruflichen Ziele

- Reaktionen auf eine experimentelle Vitamin-Ergänzungs-Kur

- Beobachtungen von Interaktionen und Praktiken am Arbeitsplatz

- Fokusgruppen Daten über das Kundenverhalten

In der Datenwissenschaft und der wissenschaftlichen Forschung gibt es nahezu unbegrenzte Möglichkeiten, Daten zu sammeln, und die wichtigste Voraussetzung ist, dass der Datensatz für die Forschungsfrage relevant und klar definiert ist. Die Forscher müssen daher alle irrelevanten Daten ausschließen, damit sie neue Theorien oder wichtige Erkenntnisse entwickeln können.

Arten von Daten

Forscher können Daten selbst erheben (Primärdaten) oder auf Daten Dritter zurückgreifen (Sekundärdaten). Die Überlegungen zur Datenerhebung, mit welcher Art von Daten gearbeitet werden soll, stehen in direktem Zusammenhang mit Ihrer Forschungsfrage und Ihren Zielen.

Primärdaten

Ursprüngliche Forschung stützt sich auf Daten aus erster Hand oder Primärdaten, die der Forscher selbst für seine eigene Analyse erhebt. Wenn Sie die Informationen in einer Primärstudie selbst sammeln, ist es wahrscheinlicher, dass Sie die erforderliche hohe Qualität erhalten.

Da der Forscher die Untersuchung, die er durchführen möchte, am besten kennt und den Forschungsprozess auf seine Untersuchung zugeschnitten hat, bietet die Erhebung von Primärdaten das größte Potenzial für die Kongruenz zwischen den erhobenen Daten und dem Potenzial, relevante Erkenntnisse zu gewinnen.

Ethnografische Forschung stützt sich zum Beispiel auf die Erhebung von Daten aus erster Hand, da die Beschreibung einer Kultur oder einer Gruppe von Menschen durch ein umfassendes Verständnis des Forschers und seiner relativen Positionierung zu dieser Kultur kontextualisiert wird.

Sekundäre Daten

Forscher können auch öffentlich zugängliche Sekundärdaten nutzen, die andere Forscher erstellt haben, um sie nach einem anderen Ansatz zu analysieren und so neue Erkenntnisse zu gewinnen. Online-Datenbanken und Literaturübersichten sind gute Beispiele dafür, wie Forscher vorhandene Daten finden können, um eine bisher unerforschte Fragestellung zu bearbeiten. Es ist jedoch wichtig, bei der Verwendung von Daten Dritter auf die Genauigkeit oder Relevanz der Daten zu achten, da der Forscher nur eine begrenzte Qualitätskontrolle der bereits erhobenen Daten durchführen kann.

Große Daten

Ein relativ neuer Aspekt der Datenerfassung und -analyse ist das Aufkommen von Big Data, bei dem Datenwissenschaftler automatisierte Verfahren zur Erfassung großer Datenmengen einsetzen.

Der Vorteil einer groß angelegten Datenerhebung besteht darin, dass eine gründliche Analyse eines größeren Datenumfangs potenziell verallgemeinerungsfähigere Ergebnisse liefern kann. Dennoch ist dies eine entmutigende Aufgabe, da sie zeitaufwändig und mühsam ist. Außerdem sind erfahrene Datenwissenschaftler erforderlich, um große Datensätze zu sichten, irrelevante Daten herauszufiltern und nützliche Erkenntnisse zu gewinnen. Auf der anderen Seite ist es für qualitative Forscher wichtig, ihren Bedarf an Datenbreite und -tiefe sorgfältig abzuwägen: Qualitative Studien stützen sich in der Regel auf eine relativ kleine Anzahl von Teilnehmern, aber für jeden Teilnehmer werden sehr detaillierte Daten gesammelt, da das Verständnis des spezifischen Kontexts und der individuellen Interpretationen oder Erfahrungen oft von zentraler Bedeutung ist. Bei der Verwendung von Big Data wird diese Datentiefe in der Regel durch eine größere Datenbreite ersetzt, die eine viel größere Anzahl von Teilnehmern umfasst. Forscher müssen ihren Bedarf an Tiefe oder Breite berücksichtigen, um zu entscheiden, welche Datenerhebungsmethode zur Beantwortung ihrer Forschungsfrage am besten geeignet ist.

Methoden der Datenerhebung

Je nach der Art der Untersuchung, die Sie durchführen möchten, gibt es unterschiedliche Verfahren zur Datenerhebung. Lassen Sie uns die gemeinsamen Datenerhebungsmethoden in der quantitativen und qualitativen Forschung untersuchen.

Quantitative Datenerhebungsmethoden

Quantitative Methoden werden verwendet, um numerische oder quantifizierbare Daten zu sammeln. Diese können dann statistisch verarbeitet werden, um Hypothesen zu testen und Erkenntnisse zu gewinnen. Die quantitative Datenerhebung zielt in der Regel darauf ab, ein bestimmtes Phänomen zu messen (z. B. den Bekanntheitsgrad einer Marke auf dem Markt, die Wirksamkeit einer bestimmten Diät usw.), um Hypothesen zu prüfen (z. B.: Marketingkampagnen in den sozialen Medien erhöhen den Bekanntheitsgrad einer Marke, der Verzehr von mehr Obst und Gemüse führt zu einer besseren körperlichen Leistungsfähigkeit usw.).

Einige qualitative Forschungsmethoden können zur quantitativen Datenerhebung und -analyse beitragen. Online-Umfragen und Fragebögen mit Multiple-Choice-Fragen können strukturierte Daten erzeugen, die dann analysiert werden können. Eine Umfrageplattform wie Qualtrics zum Beispiel fasst die Umfrageantworten in einer Tabelle zusammen, um eine numerische oder Häufigkeitsanalyse zu ermöglichen.

Qualitative Datenerhebungsmethoden

Die Analyse qualitativer Daten ist wichtig, um ein Phänomen zu beschreiben (z. B. die Anforderungen an eine gute Unterrichtspraxis), was zur Aufstellung von Thesen oder zur Entwicklung einer Theorie führen kann. Verhaltensdaten, Transaktionsdaten und Daten aus einem Social Media Monitoring sind Beispiele für verschiedene Formen von Daten, die qualitativ erhoben werden können.

Wichtig ist auch die Berücksichtigung von Instrumenten oder Ausrüstung für die Datenerhebung. Bei den Methoden der Primärdatenerhebung in der Beobachtungsforschung werden beispielsweise Audio- und Videorekorder, Notizbücher für Feldnotizen und Kameras für die Aufnahme von Fotos eingesetzt. Solange die Produkte dieser Instrumente analysiert werden können, können sie in die Datenerhebung einer Studie einbezogen werden.

Mehrere Methoden der Datenerhebung einsetzen

Darüber hinaus verlassen sich qualitative Forscher nur selten auf eine einzige Datenerhebungsmethode. Ethnografische Forscher können insbesondere direkte Beobachtung, Interviews, Fokusgruppensitzungen und die Sammlung von Dokumenten in ihren Datenerhebungsprozess einbeziehen, um die kontextbezogensten Daten für ihre Forschung zu erhalten. Mixed-Methods-Forschung setzt mehrere Datenerhebungsmethoden ein, einschließlich qualitativer und quantitativer Daten, sowie mehrere Instrumente, um ein Phänomen aus möglichst vielen verschiedenen Blickwinkeln zu untersuchen.

Neue Formen der Datenerhebung

Externe Datenquellen wie Daten aus sozialen Medien und Big Data sind ebenfalls in den Fokus der Zeit gerückt, da sich gesellschaftliche Trends ändern und neue Forschungsfragen auftauchen. Dies hat dazu geführt, dass in der Forschung neue Methoden der Datenerhebung entwickelt wurden.

Letztlich gibt es unzählige Datenerhebungsinstrumente, die für qualitative Methoden verwendet werden, aber das Hauptziel besteht darin, relevante Daten zu produzieren, die systematisch analysiert werden können. So können Forscher neben Text auch Audio, Video, Bilder und andere Formate analysieren. Da sich unsere Welt ständig verändert, z. B. durch die zunehmende Bedeutung von generativer künstlicher Intelligenz und sozialen Medien, werden Forscher zweifellos neue Untersuchungen durchführen, die eine kontinuierliche Innovation und Anpassung der Datenerfassungsmethoden erfordern.

Herausforderungen bei der Datenerhebung

Das Sammeln von Daten für die qualitative Forschung ist ein komplexer Prozess, der oft mit einzigartigen Herausforderungen verbunden ist. In diesem Abschnitt werden einige der häufigsten Hindernisse erörtert, auf die Forscher bei der Datenerhebung stoßen können, und es werden Strategien zur Bewältigung dieser Probleme angeboten.

Zugang zu den Teilnehmern

Zugang zu Forschungsteilnehmern kann eine große Herausforderung darstellen. Dies kann auf geografische Entfernungen, zeitliche Beschränkungen oder die Abneigung potenzieller Teilnehmer zurückzuführen sein. Daher müssen die Forscher den Zweck ihrer Studie klar kommunizieren, Vertraulichkeit gewährleisten und bei der Terminplanung flexibel sein.

Kulturelle und sprachliche Barrieren

Forscher können mit kulturellen und sprachlichen Barrieren konfrontiert werden, insbesondere bei interkultureller Forschung. Diese Barrieren können die Kommunikation und das Verständnis zwischen Forschern und Teilnehmern beeinträchtigen. Der Einsatz von Übersetzern, Kulturvermittlern oder das Erlernen der Landessprache kann bei der Überwindung dieser Barrieren hilfreich sein.

Nicht ansprechbare oder unkooperative Teilnehmer

Es kann vorkommen, dass Forscher auf Teilnehmer treffen, die nicht bereit oder in der Lage sind, die gewünschten Informationen zu liefern. In solchen Situationen ist es wichtig, eine Beziehung zu den Teilnehmern aufzubauen. Der Forscher sollte versuchen, Vertrauen aufzubauen, eine angenehme Umgebung für die Teilnehmer zu schaffen und ihnen die Vertraulichkeit ihrer Antworten zuzusichern.

Zeitliche Beschränkungen

Qualitative Forschung kann zeitaufwändig sein, insbesondere wenn es sich um Interviews oder Fokusgruppen handelt, die die Koordination mehrerer Termine, Transkription und eingehende Analyse erfordern. Eine angemessene Planung und Organisation kann dazu beitragen, diese Herausforderung zu bewältigen.

Verzerrungen bei der Datenerhebung

Voreingenommenheit bei der Datenerhebung kann auftreten, wenn die Vorurteile des Forschers oder der Wunsch des Teilnehmers, sich selbst vorteilhaft darzustellen, die Daten beeinflussen. Zu den Strategien zur Abschwächung von Voreingenommenheit gehören Reflexivität, Triangulation und Mitgliederkontrolle.

Umgang mit sensiblen Themen

Forschung mit sensiblen Themen kann sowohl für den Forscher als auch für den Teilnehmer eine Herausforderung darstellen. Ein sicheres und unterstützendes Umfeld, einfühlsames Zuhören und die Bereitstellung von Ressourcen für emotionale Unterstützung können helfen, diese sensiblen Themen zu bewältigen.

Das Sammeln von Daten in der qualitativen Forschung kann eine sehr lohnende, aber auch schwierige Erfahrung sein. Mit einer sorgfältigen Planung, einem ethischen Verhalten und einem flexiblen Ansatz können Forscher diese Hindernisse jedoch effektiv überwinden und solide, aussagekräftige Daten sammeln.

Überlegungen zur Datenerhebung

Die Forschung stützt sich auf Empirie und Glaubwürdigkeit in allen Phasen einer Forschungsuntersuchung. Infolgedessen gibt es verschiedene Probleme und Fragen bei der Datenerhebung, die die Forscher im Auge behalten müssen.

Probleme der Datenqualität

Ihre Analyse kann von der Erfassung feiner Details abhängen, die manche Datenerhebungsinstrumente nicht erfassen können. In diesem Fall sollten Sie sorgfältig auf die Datenqualität und die Genauigkeit Ihrer Datenerfassung achten. Denken Sie zum Beispiel an ein Bild, das mit einer Smartphone-Kamera aufgenommen wurde, und an ein Bild, das mit einer professionellen Kamera aufgenommen wurde. Wenn Sie hochauflösende Fotos benötigen, wäre es sinnvoll, sich auf eine professionelle Kamera zu verlassen, die eine angemessene Datenqualität liefern kann.

Bei der quantitativen Datenerhebung werden häufig präzise Datenerfassungsinstrumente eingesetzt, um die Ergebnisse zu bewerten, aber auch Forscher, die qualitative Daten erheben, sollten sich Gedanken über die Qualitätssicherung machen. Nehmen wir zum Beispiel an, dass eine Studie, die die direkte Beobachtung mehrere Beobachter in verschiedenen Kontexten erfordert. In diesem Fall sollten die Forscher darauf achten, dass alle Beobachter auf ähnliche Weise Daten sammeln können, damit alle Daten auf die gleiche Weise analysiert werden können.

Die Datenqualität ist ein entscheidender Faktor bei der Sammlung von Informationen. Selbst wenn der Forscher eine geeignete Methode für die Datenerhebung gewählt hat, sind die gesammelten Daten nützlich und detailliert genug, um die notwendige Analyse zur Beantwortung der gegebenen Forschungsfrage zu liefern?

Ein Beispiel dafür, wie wichtig die Datenqualität bei der Erhebung qualitativer Daten ist, sind Interviews und Fokusgruppen. Bei den Aufzeichnungen können einige der feineren Details der sozialen Interaktion verloren gehen, z. B. Pausen, nachdenkliche Worte oder Äußerungen, die nicht laut genug sind, um vom Mikrofon aufgenommen zu werden.

Angenommen, Sie führen ein Interview für eine Studie durch, bei der solche Details für Ihre Analyse relevant sind. In diesem Fall sollten Sie den Einsatz von Instrumenten in Erwägung ziehen, die ausreichend umfangreiche Daten sammeln, um diese Aspekte der Interaktion aufzuzeichnen.

Datenintegrität

Die Möglichkeit ungenauer Daten kann den Prozess der Datenanalyse beeinträchtigen, da das Ziehen von Schlussfolgerungen oder das Treffen von Entscheidungen mit minderwertigen Daten schwierig, wenn nicht gar unmöglich wird. Wenn die Integrität der Datenerhebung nicht gewährleistet ist, können die Ergebnisse einer Studie in Zweifel gezogen werden.

Die genaue Datenerfassung ist nur ein Aspekt, den Forscher zum Schutz der Datenintegrität berücksichtigen sollten. Danach geht es um die Aufbewahrung der Daten nach der Datenerhebung. Wie werden die Daten gespeichert? Wer hat Zugang zu den erhobenen Daten? Inwieweit können die Daten zwischen der Datenerhebung und der Verbreitung der Forschungsergebnisse geändert werden?

Datenintegrität ist eine Frage der Forschungsethik sowie der Glaubwürdigkeit der Forschung. Der Forscher muss sich vergewissern, dass die Daten, die zur Verbreitung der Forschungsergebnisse vorgelegt werden, das untersuchte Phänomen genau wiedergeben.

Stellen Sie sich vor, ein Foto von Wildtieren wird so alt, dass die Farben mit der Zeit verzerrt werden. Angenommen, die Ergebnisse hängen von der Beschreibung der Farben eines bestimmten Tieres oder einer Pflanze ab. Wenn in diesem Fall die Integrität der Daten nicht gewahrt wird, stellt dies eine ernsthafte Bedrohung für die Glaubwürdigkeit der Forschung und des Forschers dar. Außerdem ist es wichtig, bei der Transkription eines Interviews oder einer Fokusgruppe darauf zu achten, dass die Worte der Teilnehmer genau transkribiert werden, um eine unbeabsichtigte Veränderung der Daten zu vermeiden.

Transparenz

Wie bereits erwähnt, stützen sich Forscher bei ihren Interpretationen der Welt sowohl auf ihre Intuition als auch auf Daten. Folglich sind Forscher verpflichtet, zu erklären, wie sie Daten gesammelt haben, und ihre Daten so zu beschreiben, dass auch das Publikum sie verstehen kann. Die Schaffung von Forschungstransparenz ermöglicht es auch anderen Forschern, eine Studie zu prüfen und festzustellen, ob sie sie für glaubwürdig halten und wie sie darauf aufbauen können.

Um diesem Bedarf gerecht zu werden, enthalten Forschungsarbeiten in der Regel einen Abschnitt zur Methodik, in dem die für die Datenerhebung eingesetzten Instrumente sowie der Umfang und die Tiefe der für die Studie erhobenen Daten beschrieben werden. Es ist wichtig, jeden Aspekt der Datenerhebung und -analyse transparent darzustellen. Dazu gehören beispielsweise Beispiele für die Fragen, die den Teilnehmern gestellt wurden, demografische Informationen über die Teilnehmer oder der Nachweis, dass ethische Standards eingehalten wurden.

Subjektivität

Die Art und Weise der Datenerhebung ist ebenfalls ein zentrales Anliegen, insbesondere in den Sozialwissenschaften, wo die gesammelten Daten aus der Sicht der Menschen erstellt werden, und diese Sichtweisen können sehr unterschiedlich sein.

Bei Befragungen und Fokusgruppen kann die Art, wie die Fragen formuliert sind, die Art der von den Teilnehmern gegebenen Antworten verändern. In der Marktforschung müssen die Forscher die Fragen so gestalten, dass sie die Kunden nicht versehentlich zu einer bestimmten Antwort verleiten oder nützliches Feedback ermöglichen. Selbst in den Naturwissenschaften müssen Forscher regelmäßig überprüfen, ob die Datenerfassungsgeräte, die sie für die Datenerfassung verwenden, genaue Datensätze für die Analyse liefern.

Schließlich werfen die verschiedenen Methoden der Datenerhebung die Frage auf, ob die Daten das aussagen, was wir glauben, dass sie aussagen. Denken Sie daran, wie Menschen Überwachungssysteme einrichten könnten, um Verhaltensdaten online zu verfolgen. Wenn ein Nutzer eine bestimmte Zeit mit einer mobilen App verbringt, ist er dann wirklich mit der App beschäftigt oder lässt er sie eingeschaltet, während er andere Aufgaben erledigt?

Die Datenerfassung ist nur in dem Maße nützlich, wie die daraus resultierenden Daten systematisch analysiert werden können und für die angestrebte Forschungsfrage relevant sind. Auch wenn es verlockend ist, so viele Daten wie möglich zu sammeln, sind es die Analysen und Schlussfolgerungen des Forschers und nicht nur die Menge der Daten, die letztendlich die Wirkung der Forschung bestimmen.

Gültigkeit und Zuverlässigkeit qualitativer Daten

Die Gewährleistung von Validität und Reliabilität bei der Erhebung qualitativer Daten ist von entscheidender Bedeutung, um aussagekräftige, strenge und vertrauenswürdige Forschungsergebnisse zu erzielen. In diesem Abschnitt werden die Kernprinzipien der Validität und Reliabilität erläutert, die aus der quantitativen Forschung stammen, und anschließend werden wir relevante Qualitätskriterien für die qualitative Forschung betrachten.

Validität verstehen

Allgemein ausgedrückt geht es bei der Validität darum, sicherzustellen, dass die Forschung die Phänomene, die sie abzubilden vorgibt, korrekt wiedergibt. Sie hängt davon ab, wie gut die in einer Studie verwendeten Methoden und Techniken mit der beabsichtigten Forschungsfrage übereinstimmen und wie genau die Ergebnisse die Erfahrungen oder Wahrnehmungen der Teilnehmer wiedergeben. In der qualitativen Forschung wird jedoch häufig die Koexistenz mehrerer Realitäten anerkannt, anstatt zu glauben, dass es nur eine "wahre" Realität gibt, die gemessen werden kann. Daher können qualitative Forscher stattdessen Glaubwürdigkeit vermitteln, indem sie ihre Forschungsfrage, Operationalisierung der Schlüsselkonzepte und deren Umsetzung in ihre Datenerhebungsinstrumente und Analysen transparent kommunizieren. Darüber hinaus sollten qualitative Forscher darauf achten, ob ihre eigenen vorgefassten Meinungen oder Ziele ihre Ergebnisse ungewollt beeinflussen könnten. Darüber hinaus können potenzielle Reaktivitätseffekte in Betracht gezogen werden, um zu beurteilen, wie die Forschung ihre Teilnehmer oder das Forschungsumfeld während der Datenerhebung beeinflusst haben könnte.

Zuverlässigkeit verstehen

Zuverlässigkeit bezieht sich im Allgemeinen auf die Konsistenz des Forschungsansatzes in verschiedenen Kontexten und mit verschiedenen Forschern. Eine quantitative Studie gilt als zuverlässig, wenn ihre Ergebnisse in einem ähnlichen Kontext reproduziert werden können oder wenn ein anderer Forscher mit demselben Forschungsverfahren dieselben Ergebnisse erzielen kann.

In der qualitativen Forschung hingegen erkennen die Forscher den spezifischen Kontext ihrer Daten und ihrer Analyse an und machen sich diesen zu eigen. Alles Wissen, das generiert wird, ist kontextspezifisch. Anstatt also zu behaupten, dass die Ergebnisse einer Studie in einem völlig anderen Kontext zuverlässig reproduziert werden können, versuchen qualitative Forscher, die Vertrauenswürdigkeit oder Verlässlichkeit ihrer Daten und Ergebnisse zu demonstrieren. Transparente Beschreibungen und eine klare Kommunikation können dem Publikum vermitteln, dass die Forschung mit Strenge und Kohärenz zwischen der Forschungsfrage, den Methoden und den Ergebnissen durchgeführt wurde, was die Glaubwürdigkeit der qualitativen Studie stärken kann.

Verbesserung der Datenqualität

Zur Verbesserung der Datenqualität in der qualitativen Forschung können verschiedene Strategien eingesetzt werden. Zu ihnen gehören:

1. Triangulation: Dabei werden mehrere Datenquellen, Methoden oder Forscher verwendet, um Daten über dasselbe Phänomen zu sammeln. Dadurch kann sichergestellt werden, dass die Ergebnisse robust sind und nicht von einer einzigen Quelle abhängen.

2. Überprüfung durch die Teilnehmer: Bei dieser Methode werden die Ergebnisse an die Teilnehmer zurückgegeben, um zu überprüfen, ob die Interpretationen ihre Erfahrungen oder Wahrnehmungen korrekt wiedergeben. Dies kann dazu beitragen, die Gültigkeit der Forschungsergebnisse zu gewährleisten.

3. Detaillierte Beschreibung: Die ausführliche Darstellung des Kontexts, der Interaktionen und der Interpretationen im Forschungsbericht kann es anderen ermöglichen, den Forschungsprozess besser zu verstehen, was wichtig ist, um die Vermittelbarkeit der eigenen Forschung zu fördern.

4. Prüfpfad: Eine detaillierte Aufzeichnung des Forschungsprozesses, der Entscheidungen und Überlegungen kann die Transparenz und Kohärenz der Studie erhöhen.

Einsatz von Technologie bei der Datenerhebung

Für die Arbeit mit qualitativen Daten kann eine Vielzahl von Technologien eingesetzt werden. Technologie hilft nicht nur bei der Datenerhebung, sondern auch bei der Organisation, der Analyse und der Präsentation der Daten.

In diesem Abschnitt werden einige der wichtigsten Möglichkeiten untersucht, wie Technologie in die qualitative Datenerhebung integriert werden kann.

Digitale Werkzeuge für die Datenerhebung

Digitale Hilfsmittel können die Effizienz und Effektivität der Datenerhebung erheblich verbessern. Mit Audio- und Videoaufzeichnungsgeräten können beispielsweise Interviews, Fokusgruppen und Beobachtungsdaten sehr detailliert erfasst werden.

Online-Umfragen und -Fragebögen können ein breiteres Publikum erreichen, oft zu geringeren Kosten und mit kürzeren Durchlaufzeiten als bei herkömmlichen Methoden. Mobile Anwendungen können auch verwendet werden, um Erfahrungen, Emotionen und Aktivitäten in Echtzeit durch Tagebuchstudien oder Erfahrungsstichproben zu erfassen.

Online-Plattformen für qualitative Forschung

Online-Plattformen wie Social Media, Blogs und Diskussionsforen bieten eine reichhaltige Quelle für qualitative Daten. Forscher können diese Plattformen analysieren, um Einblicke in das Verhalten, die Einstellungen und die Erfahrungen der Menschen zu gewinnen.

Darüber hinaus werden virtuelle Gemeinschaften und digitale Ethnographie immer häufiger eingesetzt, da Forscher diese Online-Räume erforschen.

Ethische Überlegungen zur Technologie

Mit dem zunehmenden Einsatz von Technologie müssen Forscher auf ethische Überlegungen achten, einschließlich Datenschutz und Einwilligung. Es ist wichtig, die informierte Zustimmung sicherzustellen, wenn Daten von Online-Plattformen gesammelt oder digitale Tools verwendet werden, und alle Forscher sollten die notwendigen Genehmigungen für die Datenerfassung einholen und sich an alle geltenden Verhaltenskodizes (wie GDPR) halten. Bei der Speicherung von Daten auf digitalen Plattformen ist es außerdem wichtig, die Datensicherheit und Vertraulichkeit zu gewährleisten.

Vorteile und Grenzen der Technologie

Die Technologie bietet zwar zahlreiche Vorteile in Bezug auf Effizienz, Zugänglichkeit und Umfang der Daten, aber sie hat auch ihre Grenzen. So können digitale Tools beispielsweise nicht alle Nuancen und den Reichtum von persönlichen Interaktionen erfassen.

Darüber hinaus stellen technische Störungen und Datenverluste potenzielle Risiken dar. Daher ist es für Forscher wichtig, diese Kompromisse zu verstehen, wenn sie Technologie in ihren Datenerhebungsprozess einbeziehen.

So wie sich die Technologie weiterentwickelt, werden auch ihre Anwendungen in der qualitativen Forschung zunehmen. Die Nutzung dieser technologischen Fortschritte kann Forschern helfen, ihre Datenerhebungspraktiken zu verbessern, und bietet neue Möglichkeiten für die Erfassung, Analyse und Präsentation qualitativer Daten.

Datenorganisation

Datenanalyse nach dem Sammeln von Daten ist nur möglich, wenn die Daten ausreichend in eine Form gebracht werden, die leicht sortiert und verstanden werden kann. Stellen Sie sich vor, Sie sammeln Social Media Daten, das könnten Millionen von Beiträgen von Millionen von Social Media Nutzern jeden Tag sein. Sie können jeden einzelnen Beitrag in eine Datei packen, aber wie können Sie daraus einen Sinn machen?

Datenorganisation ist besonders wichtig, wenn man mit unstrukturierten Daten arbeitet. Der Forscher muss die Daten auf eine Art und Weise strukturieren, die den Analyseprozess erleichtert.

Transkription

Das Sammeln von Daten in Fokusgruppen, Interviews oder anderen ähnlichen Interaktionen erzeugt unbearbeitete Video- und Audioaufnahmen.. Diese Daten können oft auf kontextuelle Hinweise wie nonverbale Interaktion, Mimik und Akzente analysiert werden. Die meisten traditionellen Analysen von Interview- und Fokusgruppendaten profitieren jedoch von der Umwandlung der Worte der Teilnehmer in Text.

Aufzeichnungen werden in der Regel transkribiert, so dass der Text systematisch analysiert und in Forschungspapieren oder Präsentationen integriert werden kann. Die Transkription kann eine mühsame Aufgabe sein, insbesondere wenn ein Forscher stundenlange Audiodaten verarbeiten muss. Heutzutage haben Forscher oft die Wahl zwischen der manuellen Transkription ihrer Rohdaten oder der Nutzung automatischer Transkriptionsdienste, die diesen Prozess erheblich beschleunigen.

Umfragedaten

In Online-Umfrage Plattformen können die Antworten der Teilnehmer auf geschlossene Fragen einfach in einer Tabellenkalkulation zusammengefasst werden. Die Antworten auf offene Fragen können ebenfalls in eine Tabelle aufgenommen oder als separate Dateien für die spätere Analyse der von den Teilnehmern geschriebenen Texte gespeichert werden. Da Umfragedaten relativ strukturiert sind, lassen sie sich in der Regel schneller und einfacher organisieren als andere Formen qualitativer Daten, die eher unstrukturiert sind, wie Interviews oder Beobachtungen.

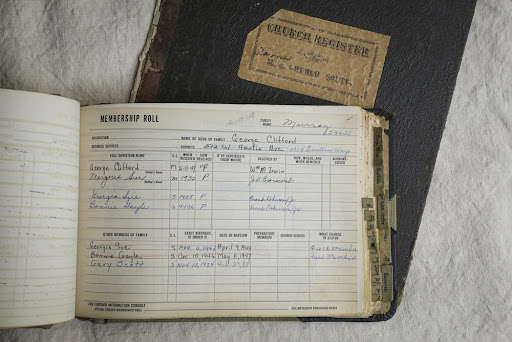

Feldnotizen und Artefakte

Bei ethnografischer Forschung oder Forschung mit direkter Beobachtung bedeutet das Sammeln von Daten oft, dass während der Feldarbeit Notizen gemacht oder Fotos aufgenommen werden. Während Feldnotizen in ein Dokument zur Datenanalyse getippt werden kann, kann der Forscher seine Notizen auch in ein Bild oder eine PDF-Datei scannen, um sie später zu organisieren.

Dieses Maß an Flexibilität ermöglicht es den Forschern, alle Formen von Daten zu kodieren, die nicht textlicher Natur sind, aber dennoch nützliche Datenpunkte für die Analyse und theoretische Entwicklung liefern können.

Kodierung

Kodieren gehört zu den grundlegendsten Fähigkeiten in der qualitativen Forschung, denn durch das Kodieren können Forscher große Datensätze effektiv in eine Reihe von kompakten Codes für die spätere Analyse reduzieren. Wenn Sie es mit Dutzenden oder Hunderten von Seiten qualitativer Daten zu tun haben, dann ist die Anwendung von Codes auf Ihre Daten eine Schlüsselmethode zur Verdichtung, Synthese und zum Verständnis der Daten.