Der ultimative Leitfaden zur qualitativen Forschung - Teil 2: Umgang mit qualitativen Daten

- Umgang mit qualitativen Daten

- Transkripte

- Feldnotizen

- Memos

- Umfragedaten und Antworten

- Bild- und Tondaten

- Organisation von Daten

- Datenkodierung

- Kodierrahmen

- Auto- und Smart-Kodierung

- Kodes ordnen

- Qualitative Datenanalyse

- Inhaltsanalyse

- Thematische Analyse

- Narrative Forschung

- Phänomenologische Forschung

- Diskursanalyse

- Grounded Theory

- Deduktives Denken

- Induktives Schlussfolgern

- Induktives vs. deduktives Denken

- Interpretation qualitativer Daten

- Software für die qualitative Datenanalyse

- Wie zitiere ich "Der ultimative Leitfaden zur qualitativen Forschung - Teil 2"

- Thematische Analyse vs. Inhaltsanalyse

Datenorganisation

Die Datenorganisation bezieht sich auf die Umstrukturierung von Rohdaten, um die Analyse zu erleichtern und Erkenntnisse zu gewinnen. Die gesammelten Daten liegen oft in umfangreicher und unstrukturierter Form vor, wie z. B. Fokusgruppen-Aufzeichnungen, Feldnotizen oder Interview-Transkripte. In diesem Kapitel wird der Prozess der Umwandlung dieser Rohdaten in einen organisierten und aussagekräftigen Datensatz beschrieben.

Datenorganisation

Die Organisation der Daten ist ein wesentlicher Bestandteil des qualitativen Forschungsprozesses. Es geht darum, die gesammelten Daten systematisch zu ordnen, um das Verständnis zu verbessern, die Analyse zu erleichtern und aussagekräftige Erkenntnisse zutage zu fördern.

Die Analogie zum Sortieren und Ablegen von Dokumenten in einem Büro drängt sich auf. Ohne Organisation hätte man Papierstapel, aber keine Möglichkeit, die benötigten Informationen schnell zu finden. In ähnlicher Weise können unorganisierte Daten den Forschungsprozess zu einer schwierigen Aufgabe machen.

Warum ist Datenorganisation wichtig?

Um die Notwendigkeit der Organisation von qualitativen Daten zu verstehen, muss man sich die gesammelten Originaldaten als Rohmaterial vorstellen. Denken Sie an die Ergebnisse Ihrer Datenerhebung Bemühungen - vielleicht umfangreiche Interviewtranskripte, detaillierte Feldnotizen, lange Beobachtungsprotokolle oder audiovisuelle Materialien.

All dies sind reichhaltige Quellen für qualitative Daten, stellen aber in ihrer Rohform eine Herausforderung dar. Ähnlich wie ungeschliffene Edelsteine verbergen diese Rohdaten ihren tatsächlichen Wert unter einem rauen Äußeren und können nicht direkt analysiert werden, um die von uns gewünschten Forschungsergebnisse zu erzielen.

Nehmen wir zum Beispiel eine Audioaufzeichnung einer Fokusgruppe. Das aufgezeichnete Gespräch ist eine Rohform von Daten. Sie enthält zahlreiche potenzielle Erkenntnisse über das Forschungsthema.

Es kann jedoch schwierig sein, sie in ihrer rohen Form zu interpretieren. Es kann sein, dass mehrere Teilnehmer gleichzeitig sprechen, oder es kann schwierig sein, den Gesprächsfluss während der gesamten Aufzeichnung zu verfolgen. Die Audioaufnahme kann in ein Transkript umgewandelt werden, um ihren Wert zu erschließen, damit der Text für die Analyse markiert und kodiert werden kann.

Dieses Beispiel unterstreicht das Grundprinzip des qualitativen Datenmanagements - dass Rohdaten verarbeitet werden müssen, bevor sie zu Erkenntnissen führen können. Dies ist vergleichbar mit der Veredelung von Erz, um Edelmetall zu gewinnen. Der Veredelungsprozess umfasst verschiedene Techniken wie Transkription, Datenreduktion und Kodierung, mit deren Hilfe die wesentlichen Elemente aus den Rohdaten herausdestilliert werden.

Die Datenorganisation ist daher ein wichtiger erster Schritt auf dem Weg von der Datenerfassung zur Analyse und schließlich zur Gewinnung aussagekräftiger Erkenntnisse. Die sorgfältige Organisation, Reduktion und Kodierung von Daten sind die wesentlichen Prozesse, die es Forschern ermöglichen, sich in der Fülle ihrer gesammelten Daten zurechtzufinden.

Herausforderung der Datenorganisation

Während Konzepte wie die konsistente Verwaltung von Dateiversionen, Dateiordnern, die Wahl einer Dateinamenskonvention und die Pflege eines Datenwörterbuchs im Vergleich zu einer tiefgreifenden Analyse von Forschungsdaten banal erscheinen mögen, erweist sich die Sicherstellung eines konsistenten Formats für die Struktur Ihrer Daten als immens wichtig für die spätere Datenklassifizierung und Datenanalyse. Durch die Anwendung dieser Techniken verwandeln sie die unhandliche, unstrukturierte Masse an Rohdaten in einen überschaubaren, strukturierten Datensatz, der für eine tiefgreifende Analyse bereit ist.

Was ist ein Beispiel für die Organisation von Daten?

Ein hervorragendes Beispiel für die praktische Anwendung der Datenorganisation ist die Art und Weise, wie Forscher mit ethnografischen Feldnotizen umgehen. Diese Notizen können zunächst eine Mischung aus Beobachtungen, direkten Zitaten, persönlichen Reflexionen und Interpretationen enthalten. In ihrer Rohform können sie jedoch schwer zu handhaben sein.

Durch die Organisation dieser Notizen - etwa nach Datum, Ort oder thematischem Inhalt - bringen die Forscher diese Mischung in eine besser strukturierte und analysierbare Form. Diese Organisation ermöglicht einen leichteren Zugang zu bestimmten Abschnitten der Notizen und erleichtert eine systematischere Analyse.

Welche Methoden verwenden Forscher, um Daten zu organisieren?

Die Organisation qualitativer Daten kann verschiedene Formen annehmen, je nach Datentyp und den spezifischen Zielen der Forschung. Die Methoden reichen von der Transkription audiovisueller Daten bis zur Erstellung von visuellen Diagrammen für beobachtete Daten.

Technologie spielt eine entscheidende Rolle bei der qualitativen Datenorganisation. Ethnografische Forschung befasst sich beispielsweise mit Feldnotizen, Interviewtranskripten, Bildern von Artefakten und reflektierenden Memos. Diese Dateien können sich in einer umfassenden Studie ohne die Verwendung von Dateiversionierung und die Verfolgung von Dateinamen für eine strenge Organisation als unhandlich erweisen.

Eine weitere häufig verwendete Methode ist die Datenreduzierung, bei der die Daten durch Techniken wie Zusammenfassen oder Paraphrasieren verdichtet werden. Dann gibt es noch das Kodieren, ein Prozess, bei dem die Daten kategorisiert und beschriftet werden, was ein wichtiger Schritt bei der Organisation von qualitativen Daten ist. Auf letzteres wird später in diesem Leitfaden noch näher eingegangen.

Insgesamt zielt die gewählte Methode darauf ab, die unstrukturierten Rohdaten in einen überschaubaren, systematischen Datensatz umzuwandeln, der für eine eingehendere Analyse vorbereitet ist. Die Bedeutung der Datenorganisation in der qualitativen Forschung kann nicht hoch genug eingeschätzt werden, da sie das Rückgrat einer effizienten, effektiven Datenanalyse bildet.

Datenreduktion

Die Datenreduktion in der qualitativen Forschung ist ein weiterer zentraler und vielschichtiger Prozess. Er beinhaltet die Umwandlung der rohen qualitativen Daten in eine besser verdauliche, fokussierte und strukturierte Form. Wenn der Umfang Ihrer Daten zunimmt, kann die Analyse von Datensätzen mehr Zeit in Anspruch nehmen als nötig. Durch die Verdichtung, Klassifizierung und Kategorisierung von Daten können Forscher große Datenmengen verständlicher machen, ohne dass das Wesentliche der Informationen verloren geht.

Die iterative Natur der Datenreduktion

Der Prozess der Datenreduktion ist kein einmaliger Vorgang, der zu einem bestimmten Zeitpunkt stattfindet. Vielmehr handelt es sich um einen iterativen und kontinuierlichen Prozess, der mit dem Beginn der Datenerhebung beginnt und sich während des gesamten Forschungsprojekts weiterentwickelt. Während sich die Forscher in die Daten vertiefen, beginnen sie, wichtige Informationen und aussagekräftige Segmente zu identifizieren, hervorzuheben und zu extrahieren.

Gleichzeitig erkennen und verwerfen sie Elemente, die möglicherweise nicht wesentlich zu ihren Forschungszielen beitragen. Dieser fortlaufende Prozess der Datenreduzierung gleicht dem Schnitzen einer Skulptur, bei dem nach und nach überschüssiges Material entfernt wird, um die Form und die Details des endgültigen Werks zu enthüllen.

Methoden der Datenreduktion

Bei der Datenreduktion kommen verschiedene Techniken zum Einsatz. Forscher können lange Erzählungen paraphrasieren, um sich auf Schlüsselpunkte oder Hauptideen zu konzentrieren und die zugrunde liegenden Konzepte zu verdeutlichen. Forscher können auch kurze Zusammenfassungen von langen Transkripten erstellen, um das Wesentliche der Diskussionen zu erfassen. Diese Strategien zielen darauf ab, die Datenmenge zu reduzieren, ohne die Integrität des Inhalts zu beeinträchtigen.

Zur Datenreduzierung gehört auch die Klassifizierung und Kategorisierung der Daten in auftauchende Themen, Themen oder Muster. Dieser Prozess ist vergleichbar mit dem Sortieren von Puzzlestücken in Gruppen, die auf ähnlichen Merkmalen basieren. Durch diese Methode können Forscher die Daten filtern und verdichten und die wichtigsten Punkte herausfiltern, die für den größeren Datensatz repräsentativ sind.

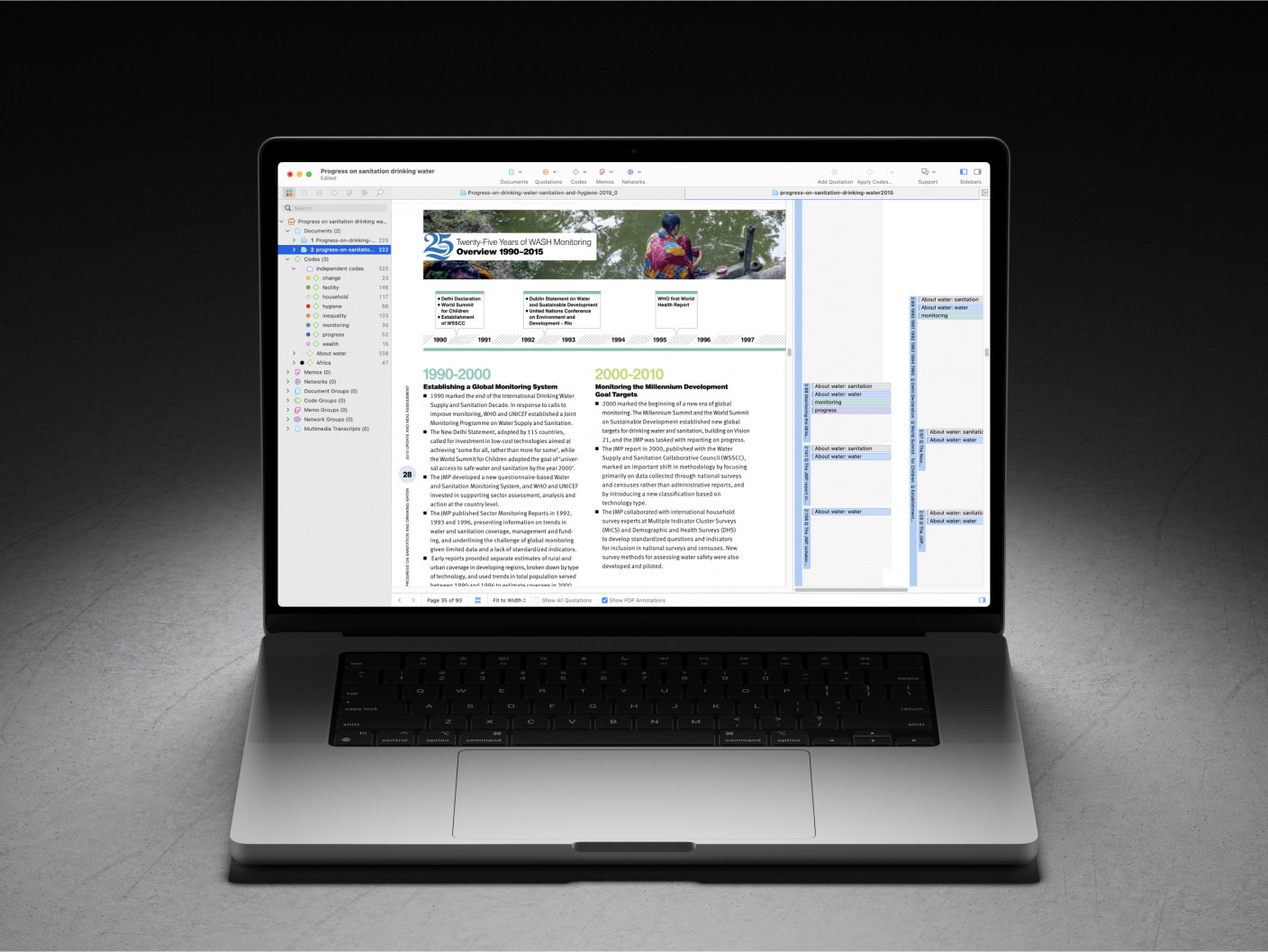

Genauigkeit bei der Datenreduktion sicherstellen

Bei der Datenreduktion muss ein empfindliches Gleichgewicht gewahrt werden. Obwohl das Ziel darin besteht, einen komprimierten und überschaubaren Datensatz zu erstellen, müssen die Forscher Vorsicht walten lassen, damit die Daten nicht zu stark vereinfacht oder falsch dargestellt werden. Trotz der Notwendigkeit der Verdichtung ist es wichtig, den Reichtum und die Tiefe der qualitativen Daten zu erhalten. Aus diesem Grund sollten sich die Forscher angewöhnen, ihre Rohdaten regelmäßig zu überprüfen. Dieser iterative Validierungsprozess hilft dabei, die reduzierten Daten gegenzuprüfen, um sicherzustellen, dass sie ihre ursprüngliche Bedeutung, ihren Kontext und ihre Feinheiten beibehalten. Qualitative Datenanalysesoftware, wie z.B. ATLAS.ti, macht es einfach, während der Datenreduzierung und -analyse zu einem bestimmten Teil der Rohdaten zurückzukehren.

Darüber hinaus ist es für Forscher entscheidend, während der Datenreduktion reflexiv zu sein und ihre Vorurteile und Einflüsse auf die Daten zu erkennen. Die regelmäßige Diskussion des Datenreduktionsprozesses mit Kollegen oder Vorgesetzten kann auch als eine Form der Validierung dienen und die Qualität der reduzierten Daten verbessern.

Das Ergebnis der Datenreduktion

Das Ergebnis der Datenreduktion ist ein kuratierter Datensatz, der sowohl weniger umfangreich als auch so strukturiert ist, dass er sich besser für weitere Analysen eignet. Stellen Sie sich diesen kuratierten Datensatz als einen sorgfältig beschnittenen Baum vor, bei dem unwichtige Äste entfernt wurden, um die Kernstruktur des Baums freizulegen. Dieser Prozess verbessert die Sichtbarkeit der wichtigen Teile und ihrer Beziehungen und ermöglicht eine effektivere Analyse.

Wichtig ist, dass der strukturierte Datensatz, ähnlich wie ein gut beschnittener Baum, die Essenz und Integrität der ursprünglichen Rohdaten bewahrt. Er dient als Grundlage für die Ableitung aussagekräftiger Erkenntnisse, Schlussfolgerungen und Empfehlungen aus der qualitativen Forschungsstudie und bildet die Grundlage für die nächste Phase des Forschungsprozesses - die Datencodierung.

Datenkodierung

Im nächsten Abschnitt dieses Leitfadens wird die Kodierung behandelt, eine weitere Form der Datenorganisation. Sie wird hier erwähnt, weil sie zwar manchmal näher an der Theorieentwicklung liegt als die eher mechanischen Prozesse der Datenorganisation, aber eine ähnliche Rolle dabei spielt, das Chaos der Rohdaten zu ordnen und ihnen eine Struktur zu geben, die eine Analyse ermöglicht.